2025年8月9日

このテキストの目的は,保健・医療分野において,主として学位論文取得を目指す大学院生を対象に,どのように研究計画をデザインし,どのように実験や調査によって生データを得て,どのようにデータファイルを作成し,どのようにデータの性質を確認し,どのように統計解析を進め,その結果を解釈して論文にまとめるか,という一連の流れのガイドラインを示すことである。神戸大学大学院保健学研究科で2012年度から担当している『エビデンスベーストヘルスケア特講』(2019年度から『保健学研究共通特講IV, VIII』)のテキストとして開発した。

なお,このテキストで統計解析において用いるソフトウェアは,2003年にピアソン・エデュケーションから『Rによる統計解析の基礎』を出版した頃から考えると信じられないほど普及しているRと,Rの代表的なGUIフロントエンドであるRcmdrを医療統計向けに自治医科大学の神田善伸先生がフルカスタマイズされたEZRである(一部他のソフトも紹介する)。

問い合わせ先:神戸大学大学院保健学研究科パブリックヘルス領域・教授 中澤 港

e-mail: minato-nakazawa@people.kobe-u.ac.jp

改版履歴

研究成果を学問として発表するためには,2つの本質的条件を満たす必要がある。第1に,これまで誰も発表したことがない,新しい発見を含んでいることである。第2に,既存の学問体系の中で,その研究を位置づけることである。誰も言ったことがないことであっても,既存の学問体系の中に位置づけることができないと,エッセイ(あるいは小説)に過ぎず,学問にはならない。どんな研究でも先行研究をレビューすることが必要なのは,このためである。研究者倫理については、日本学術振興会が発表している文書が参考になるので、どのような分野の研究者であっても読んでおくべきである。

また,人を研究対象とする場合は,倫理的な問題がつきまとうため,事前に所属機関の倫理審査委員会1に研究計画書などを提出し,審査を受けて,その研究に倫理的な問題がないことを保証してもらう必要がある。本学保健学研究科では,詳細はhttp://www.ams.kobe-u.ac.jp/for_staff/rinri/を参照されたい(ただしこのページは学内からしか見えない)。2023年4月8日現在,国の倫理指針の最終改訂は,http://www.mhlw.go.jp/stf/seisakunitsuite/bunya/hokabunya/kenkyujigyou/i-kenkyu/から見ることができる。2023年3月27日付けで人を対象とする生命科学・医学系研究に関する倫理指針(ただし,2022年6月6日付けで1つ前の版のガイダンスも出ていて,こちらの方が読みやすい)が出ている。

長い歴史から,保健医療分野に限らず,研究の進め方には一定のスタイルが確立している。どんなテーマであれ,大きく分けると,2つの型のどちらかに含まれるだろう。

研究を大別すると,問題発見型と問題解決型に分けられる(もちろん,別の分け方もあるだろうが)。

問題発見型の研究は,そのターゲットに対する研究の初期段階で行われる。例えば,パイロットスタディ,ケースレポート,記述調査,問題の定式化のための研究は,この型をとる。

それに対して,問題解決型の研究は,ある程度の研究の蓄積により,問題の所在が明確になった後で行われる。通常は標本調査で,検出力分析を用いたサンプルサイズの設計を含む適切な研究デザインが本質的に重要である。多くの場合,仮説が明確であり,サンプリング→データ→図示→区間推定や検定→有意差や相関の検出(*),モデルの当てはめというプロセスによって仮説検証を行う。

(*) 統計的有意性とP値に関するASA 声明(原文は、"The ASA Statement on p-Values: Context, Process, and Purpose"に含まれている)は、「有意差」依存を強く戒めているし、よりわかりやすく丁寧な説明が、佐藤俊哉(2024)『宇宙怪人しまりす 統計よりも重要なことを学ぶ』朝倉書店に書かれているので、一読をお勧めする。

ある程度仮説が確からしいことがわかった上で,因果関係を明らかにするために,集団を対象として行うのが介入研究である。典型的なのが,Randomized Controlled Trial (RCT:無作為化統制試験)である。例えば,新薬の有効性を調べたい時は,患者をランダムに2群に分け,片方は新薬を,もう一方は従来の標準的な薬を投与して,効果を比較する。この際,研究対象者も薬を投与する医師も,その薬が新薬なのか従来薬なのかがわからないようにして与えられる二重盲検(Double Blind)を行うのが普通である。

データを得る方法には,通常は問題発見型研究で行われるインタビューまたは質問紙(構造化/半構造化/非構造化(自由回答型)がある),観察(測定を含む),実験(動物実験やRCTを含む)に加えて,先行研究をまとめて再分析するシステマティックレビューないしメタアナリシスがある。

全数調査(悉皆調査)は,問題発見型研究に多い。母集団の基礎データを得るために実施されることがある。典型的な全数調査は国勢調査。国民健康・栄養調査のような標本調査をするための母集団の基礎情報は国勢調査から得られる。一般に用いられる統計学的手法は使えない。ただし,全数調査の中から標本を抽出して詳細な集計を行ったり関連性を調べたりすることは行われている(国勢調査の場合だと,約1%の調査票を使った速報集計や,抽出詳細集計がそれに当たる)。

統計解析の対象になるデータは,大抵の場合,標本調査によって得る。仮説検証型研究,動物実験,介入研究では適切な標本抽出(サンプリング)が必須である。臨床研究では,ある期間内に集まった症例数で妥協するしかない場合があるが,あくまで妥協と考えるべきである。原則として標本サイズはきちんと設計する必要がある(詳しくは後述)。動物実験や介入研究ではとくにクリティカル(サンプルサイズが小さくて検出力が足りなかったために有意な差が検出できなかったという言い訳は通用しない)。

最近流行のビッグデータは,(多くの場合自動的に記録される,従来のリレーショナルデータベースでは処理しきれないほど)大量のデータのことだが,全数調査ではない。かといって計画された標本調査でもない。本来,母集団が何かということに注意を払うべきだろうが,あまり考慮されていないようにみえる。しかし,手に入った範囲の大量のデータを短時間で高速に処理することで,限定的な特性の概略の傾向を掴むことがビッグデータ解析の目的であることが多いので,それでも実用上の意味はあるのだろう。

こうしてテーマに対するアプローチが決まったら,次にすることは,研究計画を立てることである。その後で研究を実施し,信頼できるデータを得て,データ解析をして,先行研究と比較しながら結果を解釈することになる。

大学院生の研究は,多くの場合,テーマを絞った問題解決型の標本調査になると思われるので,研究計画を立てる上で,サンプルサイズの計算が必須になる。そこで,先に進む前に,統計ソフトについて紹介しておく。現在では,SAS,JMP,SPSS等さまざまな統計解析ソフトが利用できるが,このテキストでは代表的なフリーソフトウェアであるRと,それをGUIで操作でき,医学統計解析向けの関数を整備したEZRを使った操作について説明する。神戸大学では図書館のコンピュータのSPSSのライセンス契約は2016年度末で切れたため,研究科としてもRまたはEZRを使うことが推奨されている。

RはMS Windows,Mac OS,Linuxなど,さまざまなOSで動作する。中間栄治さんが早い段階で開発に参加してくださったおかげで,テキスト画面でもグラフィック画面でも日本語の表示が可能だし,岡田昌史さんや間瀬茂さんを中心に組織されたユーザグループの協力によって,インターフェースの多くの部分で日本語に翻訳されたメッセージが利用可能である2。Windows版やMac OS版は,通常,実行形式になっているものをダウンロードしてインストールする。Linuxではtarで圧縮されたソースコードをダウンロードして,自分でコンパイルすることも難しくないが,ubuntuなどではコンパイル済みのバイナリを提供してくれている人もいるので,それを使う方が容易にインストールできるかもしれない。

Rはフリーソフトなので,自分のコンピュータにインストールすることも自由にできる。R関連のソフトウェアはCRAN (The Comprehensive R Archive Network)からダウンロードすることができる。CRANのミラーサイトが世界中に存在し,ダウンロードは国内のミラーサイトからすることが推奨されているので,日本では統計数理研究所のサイト3を利用すべきだろう。

2025年4月25日現在、Rの最新版は、4月11日にリリースされたR-4.5.0(コード名"How about a twenty-six?")である。Rはバージョンごとに開発コード名が付いているが、その出典が漫画Peanuts!なのは有名であり、R-4.5.0のコード名の出典は、ゼロでない何者かになりたいというチャーリー・ブラウンに対して、ルーシーが5? 26はどう? 1/72? わかった、平方根ね! と畳み掛ける途中で出てくる数字であり、たぶんとくに意味があるわけではない。2024年4月24日にリリースされたR-4.4.0の"Puppy Cup"は、スヌーピーが地域の子犬大賞にノミネートされて大騒ぎしたという話であった。ちなみに2月29日にリリースされていた4.3.3のコード名は"Angel Food Cake"で、道に迷ったチャーリー・ブラウンが、お腹が空いてAngel Food Cakeが食べたいなあ、と漏らすと、ウッドストックがレシピを語るというシュールな回、4.3.2の"Eye Holes"は、リリース日がハロウィン近かったので、子どもがハロウィンでお化けの仮装をするのに布に目出し穴を開けるのを忘れて見えない、というネタ、4.3.1のコード名は"Beagle Scouts"で、初出から50周年を記念する特設サイトができているくらい有名なテーマだった。

R-4.1.*からネイティブなパイプ記法が導入されるなど大きく機能追加された。2022年4月にリリースされたR-4.2.0でも大きな変化があり、とくにWindows版では、UTF-8をネイティブサポートしたため、R-4.1.*以前にShift-JISで書いていたコードをR-4.2.*のコンソールで開くと文字化けする(日本語コード指定できるエディタで変換するか、Chromeなどのブラウザで開いて文字化けしていない状態でコピーし、コンソールやスクリプトウィンドウにペーストすれば問題ない)。Rtoolsも4.2に変わった。MSVCRTではなくUCRTに依存しているためWindows10 (1903)以上でない場合、Rより先にUCRTのランタイムをインストールする必要がある。32ビット版もサポートしなくなるなど変化が大きいが、もはや大半のWindowsユーザはWindows 10かWindows 11で、64ビットプロセッサであろうから、個人的には良いと思う。グラフィックデバイスの扱いが変わり4、これまで入っていたパッケージもすべてRtools42以降を使ってビルドし直して再インストールする必要がある。2025年4月25日現在のRtoolsの最新版はRtools45である。

R-4.5.0-win.exe)をダウンロードし,ダブルクリックして実行する。インストール途中で,スタートアップオプションをカスタマイズするかどうか尋ねるダイアログが表示されるので,ここはいいえ(デフォルト)でなく,はい(カスタマイズする)の方をマークして「次へ」をクリックすることをお薦めする5。次に表示されるウィンドウでSDI (separate windows)にチェックを入れて「次へ」をクリックするのが重要である。他のオプションは好みに応じて選べば良い。なお,後でRcmdr/EZRをインストールしたい場合は,Windows自体のログインユーザ名に全角文字(2バイトコード)を使わない方が良い。R-4.5.0.tar.gzをダウンロードして展開して自力でコンパイルする。最新の環境であれば,./configureとmakeしてから,スーパーユーザになってmake installで済むことが多いが,場合によっては多少のパッチを当てる必要がある。なお、マルチコアのCPUに対応したRevolution Rが開発されていたが、開発していたRevolution Analytics社がMicrosoftに買収された後、引き続きMicrosoft R OpenとしてMRAN (Microsoft R Application Network) 7からダウンロードできる状態が暫く維持されていたものの、2023年7月1日にサイトが廃止された8。

以下の解説はWindows版による。基本的にLinux版でもMac OS X版でも大差ないが,使えるグラフィックデバイスやフォントなどが多少異なるので,適宜読み替えられたい。なお,以下の本文中,\記号は¥の半角と同じものを意味する。

Windowsでは,インストールが完了すると,デスクトップまたはクイック起動メニューにRのアイコンができている。Rguiを起動するには,デスクトップのRのアイコンをダブルクリックするだけでいい9。ウィンドウが開き,作業ディレクトリの.Rprofileが実行され,保存された作業環境.RDataが読まれて,

>と表示されて入力待ちになる。この記号>をプロンプトと呼ぶ。Rへの対話的なコマンド入力は,基本的にプロンプトに対して行う。閉じ括弧を付け忘れたり命令や関数の途中で改行してしまった場合はプロンプトが継続行を意味する+となることに注意されたい。なお,Windowsでは,どうしても継続行状態から抜けられなくなってしまった場合,キーを押すとプロンプトに戻ることができる。

入力した命令や関数は,「ファイル」メニューの「履歴の保存」で保存でき,後で「ファイル」のSourceで呼び出せば再現できる。プロンプトに対してsource("プログラムファイル名")としても同じことになる(但し,Windowsではファイルパス中,ディレクトリ(フォルダ)の区切りは/または\\で表すことに注意10。できるだけ1つの作業ディレクトリを決めて作業することにする方が簡単である)。

また,キーボードの↑を押せば既に入力したコマンドを呼び戻すことができる。

なお,Rをインストールしたディレクトリのbinにパスを通しておけば,Windows 8/8.1/10/11のコマンドプロンプトでRと打っても,Rを起動することができる。この場合は,コマンドプロンプトがRコンソールの代わりにシェルとして動作する。もっといえば,Makefileを書いておき,makeを使ってRを実行することもできる。下枠内のように書いたバッチファイル(make.cmdとか)を作っておき,INPUT.RにRのコードを書き,バッチファイルをダブルクリックして実行させ,結果がoutput.txtに保存されるように設定することもできる。

Rterm --vanilla < ./INPUT.R > output.txtq()<- 例えば,1,4,6という3つの数値からなるベクトルをXという変数に保存するには次のようにする。

X <- c(1, 4, 6)function() 例えば,平均と標準偏差を計算する関数meansd()の定義は次の通り。

meansd <- function(X) { list(mean(X), sd(X)) }install.packages() 例えば,CRANからRcmdrパッケージをダウンロードしてインストールするには,

install.packages("Rcmdr", dep=TRUE)dep=TRUEはdependency(依存)が真という意味で,Rcmdrが依存している,Rcmdr以外のパッケージ(かなりたくさんある)も自動的にダウンロードしてインストールしてくれる。なお,TRUEはTでも有効だが,誤ってTを変数として別の値を付値してしまっていると,意図しない動作をしてしまい,原因を見つけにくいバグの元になるので,できるだけTRUEとフルスペル書いておくことが推奨されている。? 例えば,t検定の関数t.testの解説をみるには,?t.testとする。関数定義は何行にも渡って行うことができ,最終行の値が戻り値となる。関数内の変数は局所化されているので,関数内で変数に付値しても,関数外には影響しない。関数内で変数の値を本当に変えてしまいたいときは,通常の付値でなくて,<<-(永続付値)を用いる。

このようなコマンドベースの使い方に習熟するには一定の時間が必要である。世界各地でRユーザが開発した追加機能パッケージが多数公開されているが,なかでもカナダ・マクマスタ大学のJohn Fox教授が開発したRcmdr(R Commander)は,メニュー形式でRを操作できるパッケージとして有名である。Rcmdrのメニューはカスタマイズすることができるし,プラグインという仕組みで機能追加もできるので,自治医科大学の神田善伸教授が医学統計向けにフルカスタマイズし機能追加したものがEZRである11。

R CommanderやEZRをインストールすれば,メニューから選んでいくだけで多くのRの機能を使うことができるので便利である。ただし,メニューに入っていない機能も多いので,必要に応じて,スクリプトウィンドウに直接Rの関数を打ち,実行したい範囲を選択して「実行」ボタンをクリックする必要がある。

EZRをインストールするには,Rcmdrをインストールした後で,

install.packages("RcmdrPlugin.EZR", dep=TRUE)と打てばよい12。

Rcmdrのメニューを起動するには,プロンプトに対してlibrary(Rcmdr)と打てばよい。暫く待てばR CommanderのGUIメニューが起動する。なお,いったんR Commanderを終了してしまうと,もう一度library(Rcmdr)と打ってもRcmdrは起動しないので,Commander()と打つ。ただし,detach(package:Rcmdr)と打ってRcmdrをアンロードしてからなら,もう一度library(Rcmdr)と打つことでR CommanderのGUIメニューを呼び出すことができる。

そこからEZRを呼び出すには,メニューの「ツール」から,「Rcmdrプラグインのロード」を選び,プラグインとしてRcmdrPlugin.EZRを選んでOKボタンをクリックする。少し待つと,「Rコマンダーを再起動しないとプラグインを利用できません。再起動しますか?」と尋ねるダイアログが表示されるので,「はい(Y)」をクリックするとEZRが起動する13。

なお,オリジナルのRcmdrメニューも「標準メニュー」として残っているので,EZRであってもRcmdrとしての標準的な使い方ができる。

Rには,Rcmdr/EZRの他にもいくつかのフロントエンドとなるソフトウェアが存在する。統計解析の機能としてはRを使うのだけれども,操作するためのフロントエンドとして,Rコンソールよりも多機能なソフトをかぶせることによって操作性を改善するものである。

統計解析の専門家やパッケージ開発者に人気なのが,RStudio14である。R本体と同様に,Windows版,MacOS版,Linux版が存在する。RStudioの利点はいろいろあるが,プロジェクトという単位でコードを管理できるのが大きい。パッケージ作成者がメンテをするには,ほぼ必須のツールといえる。オブジェクトの一覧が常時得られていて,それらの中身を確認する際もRコンソールより遙かに見やすい。ただ,Rcmdr/EZRとは組み合わせにくいので,たぶん初心者はRcmdr/EZRで,中級者以上になったらRStudioを使うのがいいだろう。筆者はRコードとそれをRtermを使って実行するためのスクリプトを書いてファイラからバッチ実行するという使い方をすることも多いが,普通はRStudioで十分である。

日本で開発されたフロントエンドで,フローチャートとして分析プロセスを操作するとコードが生成される点に特徴があるのが,R AnalyticFlow15である。分析の流れを可視化してくれるのは便利だし,他にも便利な機能は多い。これもR本体と同様,Windows版,MacOS版,Linux版が存在する。Rcmdr/EZRよりもコード実行を意識するし,RStudioよりもコードの流れはわかりやすいので,初心者が中級者に移行するときに役に立つかもしれない。デバッグ機能が優れているので,中級者以上でもRStudioよりR AnalyticFlowが好きだという人も珍しくない。

jamovi17も計算のバックエンドにはRを使うことができるが(Rのコードを出力させることができる),SPSSのようにデータの属性をビジュアルに指定し,表を見ながら統計手法を選んで使うソフトのようである。Rzに似ている思想と思われるが,パッケージではなくRStudio同様,独立したソフトウェアとしてインストールする。WindowsでもMacOSでもLinuxでも動作させることができる。

特筆すべきは,“Learning Statistics with jamovi”18というフリーテキストが提供されていることである。このテキストには,芝田征司氏による日本語訳『jamoviで学ぶ心理統計』19も存在する。元の“Learning Statistics with jamovi”は,David Foxcroft氏が,Danielle Navarro氏によるテキスト“Learning Statistics with R”20の使用ソフトをRからjamoviに置き換えて作成したものであり,心理統計の入門書としても大変参考になる。

最近では,SASやSPSSからもRを呼び出して使うことができるようになった。また,構造方程式モデリングのためにR本体への追加パッケージとしてsemやlavaanを用い,モデル自体をGUIで操作できるフロントエンドとしてΩnyx21を使うとか,階層ベイズモデルのためにRにはRStanパッケージをインストールして,Stan22と連動させて使うなど,高度な統計解析のために他のソフトウェアと連動させて使うことも広く行われている。このあたりが,Rのオープンさゆえの長所だと思う。

2016年に入り,2015年にRevolution社を買収したMicrosoftが,C#, Visual Basic, F#, C++, JavaScript, TypeScript, Pythonなど多くの言語の開発環境であるVisual StudioをRに対応させるR Tools for Visual Studio23をリリースした。他の言語でVisual Studioを使い慣れているプログラマにとっては便利かもしれない。

研究計画に入る前に,もう1つ説明しておかねばならない。統計解析を要する研究においては測定が必須であり,その測定は「正しく」なければならない。この章では,まず測定の正しさについて説明し,保健・医療の分野で集団を対象として正しい測定をするために必要な,疾病量と疾病量への効果を把握する疫学的な方法論の基礎について簡単に解説する。詳細はRothman (2012)などを参照されたい。

測定の正しさを考えるとき,少なくとも3種類の異なる正しさが存在することに注意したい。Validity (妥当性),Accurary(正しさ・正確性),Precision(精度)の3つである。

Validityとは,測りたいものを正しく測れていることである。例えば,ELISAで抗体の特異性が低いと,測定対象でないものまで測ってしまうことになるので,測定の妥当性が低くなる。途上国で子供の体重を調べる研究において,靴を履いた子供がいてもそのまま体重計に載せて,表示された値を使ったという研究があったが,そういうときの靴は往々にしてブーツなので1 kg近くの重さがある場合もあり,表示値そのままでは体重が正しく測れていない。また,測定すること自体が測定値に影響を与えてしまうと,妥当性は損なわれてしまう。例えば,心理的ストレスに対して何らかの物質の血中濃度が鋭敏に反応するとしても,採血自体がストレスを与えてしまう可能性があるので,その物質の測定値が高いという結果が出ても,元々ストレスが掛かっていたのか,採血がもたらしたストレスのせいで高値になったのか判別不能なので,短期的ストレス評価の指標として血液を含む侵襲的なサンプル採取を伴うと妥当性は損なわれる。もちろん,侵襲度が低ければ良いというものでもない。ストレス評価の場合,POMS-Jのような質問紙は非侵襲,心拍や唾液や光トポグラフィや脳波は低侵襲,血液は高侵襲だが,高侵襲な指標ほど真に測りたいものに近いので妥当性が高いことが多い。長期的なストレスを判定したい場合ならば,血液中の物質で,長期にわたる心理的ストレスに応じて高濃度になるが,短期的なストレスに対しての応答速度が速くない物質を測定すれば,妥当性が高くなる。ただし一般に,そこまで高い妥当性が必要でなければ低侵襲な方が倫理的に良い。

Accuracyとは,バイアス(系統誤差)が小さいことである。モノサシの原点が狂っていると(目盛幅が狂っているときも),正しさが損なわれる。例えば,何も載っていない状態で1 kgと表示されている体重計で体重を測定すると,真の体重が60 kgの人が載ったときの表示は61 kgとなるだろう。すべての人の体重が1 kg重く表示されたら,正しいデータは得られない。

Precisionは,確率的な誤差(ランダムな誤差)が小さいことである。信頼区間が狭い,CV(変動係数)が小さいこととも同義である。一般に感度の低い測定は精度が低くなる。例えば,手の大きさを測るのに,通常のものさし(最小表示目盛が1 mm)で測るのと,ノギス(最小表示目盛0.1 mm)で測るのでは,最小目盛の1/10まで読むとしても,精度が1桁異なる。

信頼性は安定性,再現性(test-retest reliability)や測定者間一致度(inter-observer concordance)や項目間一致度(Cronbachのα係数等)で示される。系統誤差がない場合,信頼性が高い測定ができれば,一般に妥当性もある。

本質的に直接測定が不可能な場合(質問紙によるストレス評価など),3種の妥当性を確保する必要があると言われてきた。

しかし,村山(2012)は,妥当性とは構成概念妥当性のことであり,他の「○△妥当性」は構成概念妥当性を検証するための方法・証拠のタイプと述べている。つまり,内容的証拠(専門家が妥当と判断するということ),収束的証拠(類似概念を知るためのテスト指標と高い相関があること),弁別的証拠(異なる概念を知るためのテストと低い相関しかないか無相関なこと),のように考えるべきとしている。

正確な測定には,ゼロ点調整が重要である。例えば,電子天秤で秤量するとき,試薬皿を載せた状態でtareしておかないと,試薬皿の重さだけ少なく量ってしまう。原点を通る検量線を描きたいとき,ブランクで吸光度がゼロになるように調整する(このときのブランクは水ではなく,対象物質の濃度がゼロで試薬は入っている,試薬ブランク)。

正確さを保証するには,例えば,標準物質の測定結果がcertified rangeに入っているかどうかを確認する(certified range自体の正しさは複数のreference laboでの測定で相互保証)。

正しい検量線を作る方法としては,以下2つが知られている。

精度を保つ方法としては,同一サンプルを繰り返し測定(またはduplicateやtriplicateで同時に測定)して,CVが小さいことを確かめることが,よく行われる。CV (Coefficient of Variation)とは,標準偏差を平均値で割った値(通常は100を掛けて%表記)である。

発想としては,測定値が真値±測定誤差の結果であり,測定誤差が平均ゼロの正規分布に従うと考え,誤差の標準偏差が測定値そのものに比べて十分小さい(例えば5%未満)なら測定値は信用できると考える。

異なるサンプルの測定値のばらつきを示すのにCVを使うのは誤用であり,その目的なら標準偏差そのものを見るべきである。また,サンプルから母集団におけるデータのばらつきを推定するには不偏標準偏差(不偏分散の平方根)を用いる。

サンプルから母集団の平均値を繰り返し推定した場合,その平均値がどの程度ばらつくか(即ち平均値の標準偏差)を示すのが標準誤差。サンプルから得られた不偏標準偏差をサンプルサイズの平方根で割った値になる。平均値が欲しいなら,標準誤差が小さいほど精度は高くなる。つまり,サンプルサイズが大きいほど精度は上がる。

疫学調査では,通常,「疾病/非疾病」と「曝露/非曝露」の関連性を調べるため,2つのカテゴリ変数間の関連性の程度をクロス集計により評価するのが普通である。

これを別の角度からみると,曝露群と非曝露群の間で,疾病量を比較することに相当する。疾病量の指標としては,prevalence(有病割合)またはodds(オッズ),risk(リスク),incidence rate(罹患率)を区別する必要がある。

疾病と曝露の関連性の程度【=effect(効果)】の評価法としては,difference(差)でみるか,ratio(比)でみるかを区別して考えるべきである。どちらも一長一短であり,目的に応じて使い分けるべきである(下表)。

| 疾病量の指標 | 差 (difference) | 比 (ratio) |

|---|---|---|

| 罹患率 (incidence rate) | 罹患率差(=率差) =曝露群の罹患率-非曝露群の罹患率 |

罹患率比(=率比) =曝露群の罹患率/非曝露群の罹患率 |

| リスク (risk) | リスク差 =曝露群のリスク-非曝露群のリスク | リスク比 =曝露群のリスク/非曝露群のリスク |

| オッズ (odds) | (なし) | オッズ比 =要因あり群の疾病オッズ/要因なし群の疾病オッズ =症例群の曝露オッズ/対照群の曝露オッズ |

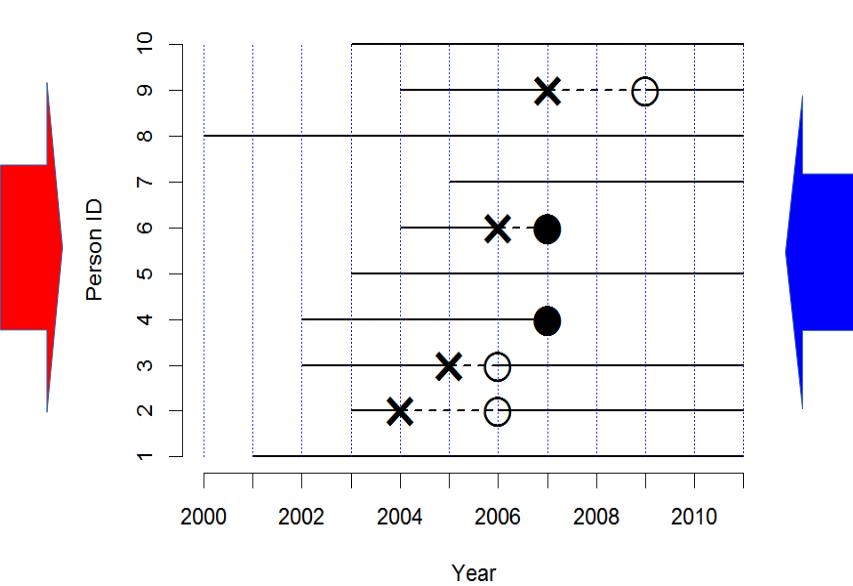

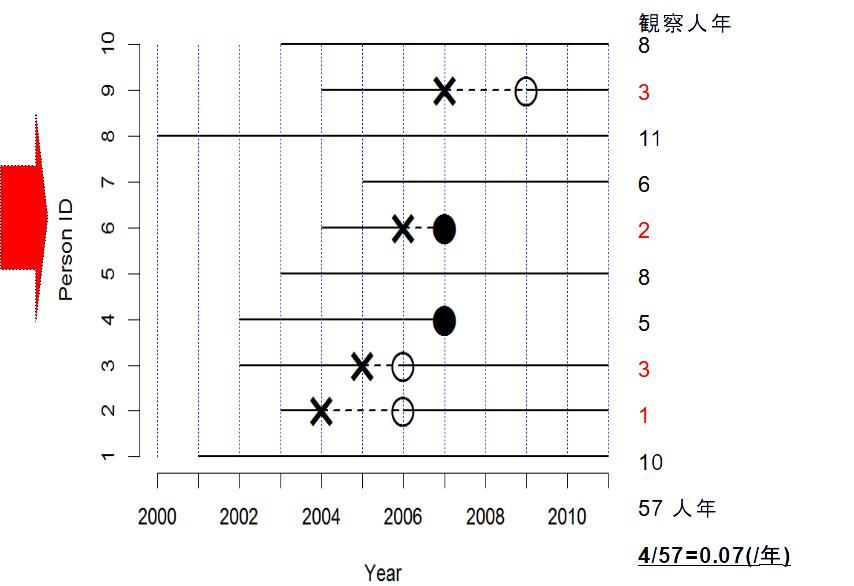

疾病発生の実際の状況を考えてみよう。下図では,横線のそれぞれが1人の個人を意味し,実線は健康,破線は疾病である状態を示す。×は疾病罹患,○は治癒,●は死亡を意味する。横軸は観察年を意味する。

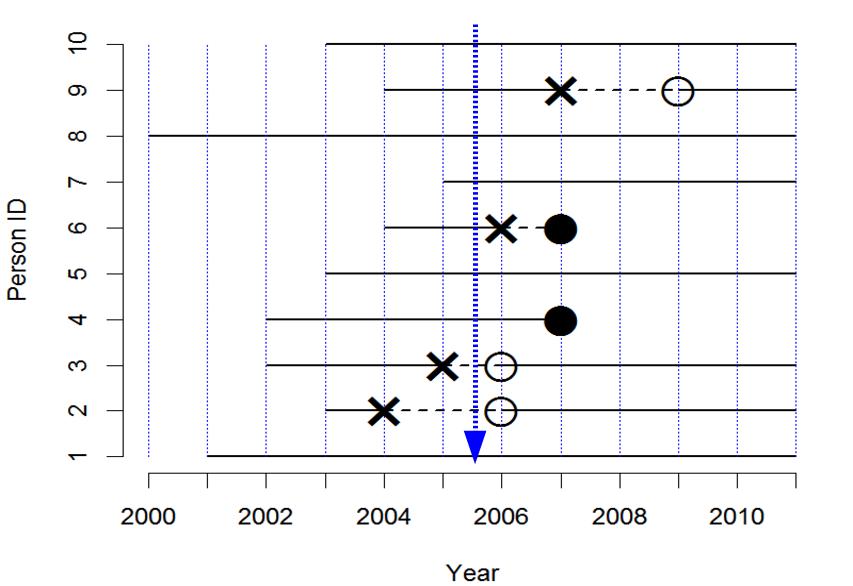

まず,有病割合 (prevalence)とは,ある時点で,全体の中でどれくらいの割合の人が病気かを意味し,以下のようにして求める。例えば,2005年半ばに横断研究をすると(下図青矢印),10人の人がいて,うち2人が病気なので,有病割合は2/10で0.2となる(なお,似て非なる概念である疾病オッズ24は2/8で0.25である)。調査が簡単なのが利点だが,2010年半ばに横断研究をすると,有病割合は0/8で0となってしまうこと(下図赤矢印)からわかるように,ある瞬間の情報しか与えてくれないという欠点がある。

次に,リスク (risk)は,累積罹患率 (cumulative incidence rate)ともいい,最初にいた観察対象人数を分母,観察期間内に病気を発症した人数を分子として求めた,罹患の確率を意味する。当然,観察期間が長いほど,大きい値になる傾向がある。2011年に生き残っている8人の子供について親に過去の罹患について思い出してもらい(下図青矢印),3人について疾病罹患が報告されたなら,この11年間のリスクは3/8=0.375と推定される。このような後ろ向きの研究は簡単で安価にできるが,既に亡くなった子供の情報を聞き逃してしまう欠点をもつ。逆に,2000年から11年間のコホート研究をした場合は(下図赤矢印),10人の子供のうち疾病罹患は4人が経験したので,11年間のリスクは0.4となる。ただし生後1年間に同じ病気に罹るリスクは1/10=0.1となる。この例から,リスクは観察期間に依存することが良くわかる。

観察期間に依存しない指標を得るには,分母を人数でなく,延べ観察人年にすればよい。この発想で得られる指標が,罹患率 (incidence rate)である。上図赤矢印と同じく2000年からコホート研究すれば全人年データを観察できる25。下図のように数えた感受性のある観察期間の合計人年を分母,疾病発生数を分子にした値が「罹患率」(incidence rate)となる。罹患率は,(1/年)という次元をもつ(時間当たりの件数,即ち発生速度を意味する)。実際に計算してみると,57観察人年のうち4例発症しているから,4/57で約0.07(/年)となる。

なお,何度も罹患する疾病について,集団の罹患率を求めるには,年央のリスク人口を分母,その年の疾病発生数を分子とすると,罹患率が得られる(通常,10万人年当たりで計算する)。感染症サーベイランス事業で医師が診断したときに全数報告することになっている疾患については,報告数を年央人口で割ることによって毎年の罹患率が計算できるが,定点報告疾患や,あるいは罹患しても医療機関を受診しないような軽い疾患については,この方法で罹患率を求めることはできない。

観察のエンドポイントを疾病発生から死亡に変えると,罹患率の代わりに死亡率が計算できる。この例では,下図のように0.027/年となる。罹患率と同様に,大集団についての指標としては,年間死亡数を年央人口で割るとその年の死亡率が得られる(通常,1000人年または10万人年当たりで表す)。この例は小標本だから不適切だが,仮に下図で計算すると,2007年に0.2/年,他の年は0となる。

典型的な比較方法には,差(絶対比較)と比(相対比較)がある。両方ともそれぞれ意味がある。

比較する疾病量による違いがあり,リスクの場合は,リスク差またはリスク比を求める。罹患率の場合は,罹患率差または罹患率比を求める。また,死亡率の場合は死亡率差または死亡率比を求める(これらを総称して率差とか率比とかいう)。しかし,有病割合の場合は,オッズ比を用いるのが普通であり,有病割合の差を比べることはあまりない。

絶対比較は,リスク差または率差による。疫学では寄与危険とか超過危険と呼ぶ。

架空の例を考えてみる。高圧線の近くの住民10万人(曝露群)を5年間追跡調査して,毎年2人ずつ白血病患者が見つかったとする。高圧線から離れたところの住民10万人(非曝露群)を同じ期間追跡調査して,毎年1人ずつ白血病患者が見つかったとする。この人たちに居住地以外の(教育歴とか年収とか人種とか気候とか)違いはないものとする。

このとき,リスク差は, 10/100000 − 5/100000 = 5/100000( = 0.00005)

罹患率差は, 10/(100000 + 99998 + 99996 + 99994 + 99992) − 5/(100000 + 99999 + 99998 + 99997 + 99996) ≒ 0.0000100006(/year)

罹患率自体が非常に小さいので,差は小さく見える。

同じ例で,リスク比と罹患率比を考えてみる。 リスク比は, (10/100000)/(5/100000) = 2

罹患率比は,  ≒ 2

≒ 2

どちらの値も,「高圧線の近くに住むと白血病のリスクが約2倍になる」ことを意味する。統計学的に有意かどうかを調べるには,「母集団における比が1」という帰無仮説を検定する。R (EZR), SAS, JMPのようなソフトを使えば簡単で,p値は0.2より少し小さい程度なので有意水準5%では有意でない(fmsbパッケージを使って,下枠内のようにRコンソールで打てば,点推定量とともに,95%信頼区間やp値も示される)。

library(fmsb)

riskratio(10, 5, 100000, 100000)

rateratio(10, 5, 100000+99998+99996+99994+99992,

100000+99999+99998+99997+99996)先に示した例で,2005年に横断的研究をしたときのオッズ比を考えてみる。下図の状況である。

横断的研究では有病割合が疾病量の指標になる。しかし通常,有病割合そのものの差や比は評価しない。代わりにオッズ比を計算する。ここで,偶数番号の人が喫煙者,奇数番号が非喫煙者だったとする。喫煙者の疾病オッズは1/4,非喫煙者の疾病オッズも1/4となるので,オッズ比は(1/4)/(1/4) = 1となる。

症例対照研究では,オッズ比は症例の曝露オッズ(曝露有りの人数の曝露無しの人数に対する比)を対照の曝露オッズで割った値になる。もし2005年に2番と3番の人が症例として見つかった人で,他の8人が対照として標本抽出された人だったとすると(かつ偶数番号の人が喫煙者),オッズ比は (1/1) / (4/4) = 1となり,これら2つのオッズ比は一致する。

白血病の例では,有病割合が低いので,横断的研究で十分な検出力を得るためには大きなサンプルサイズが必要になるし,コホート研究で高圧線の近くに住むことの影響を調べるデザインも,比較的大きなサンプルサイズと長期間の観察を必要とするので効率が悪い。そのため,症例対照研究で,ある病院を一定期間に受診した白血病患者全員を症例とし,同じ病院を外傷で受診した人を対照としてリクルートし,居住場所が高圧線の近くかどうかを尋ねるのが常道である。

例えば,白血病患者100人のうち,高圧線の近くに住んでいる人が20人,外傷患者200人のうち,高圧線の近くに住んでいる人が20人だったとすると,オッズ比は以下のように計算できる。 (20/80)/(20/180) = 18/8 = 2.25

このオッズ比の統計学的有意性を検定するのに,Rでは以下のようにする。fisher.test()関数とfmsbパッケージのoddsratio()関数では若干のずれがあるが,いずれもp値は0.05より小さく,高圧線の近くに住むことが,有意水準5%で統計学的に有意に白血病罹患と関連しているといえる。

> fisher.test(matrix(c(20, 80, 20, 180), 2)) #オッズ比は最尤法での反復推定値

> library(fmsb)

> oddsratio(20, 80, 20, 180) #定義通りのオッズ比,正規近似によるp値,信頼区間EZRの場合は,メニューの「統計解析」→「名義変数の解析」→「分割表の直接入力と解析」と進んで,表示されたウィンドウの中に2×2の分割表があるので,それぞれに20, 80, 20, 180と入力してOKボタンをクリックすれば,fisher.test()と同じ結果が得られる。

大学院在籍期間中に研究に応じてくれた患者の数が限られていたため,要因Yが結果Z(通常,その病気であること)と関連がないという特定の帰無仮説Xを検定するために,10人の患者(とそれに対応する1~3倍程度の対照群)しか調査できなかったとする。検定の結果,有意水準5%で帰無仮説Xは棄却されなかったとする。

公表バイアス(publication bias)を避けるためには,こういう,「統計学的に有意でない」結果も,“Lack of association ...”のようなタイトルを付けて投稿すべきである。しかし,おそらく査読者は,この研究結果が「有意でなかった」のは,サンプルサイズが小さかった(言い換えると,検出力が足りなかった)からと判定する。これは研究デザインの致命的な欠点なので,論文はリジェクトされる。

大学院生としては学位が欲しいので,ここで統計学者に助けを求めることが多いのだが,この段階ではもはや手遅れ(せいぜい言い訳の仕方を教えるくらいしかできない)。良くある悲劇である。

では,どうすれば良かったのだろうか? この研究は,仮説検定という枠組みで行われた。サンプルサイズを大きくすれば統計的検出力が大きくなることは既知なので,研究開始前に,十分な統計的検出力を得るために必要なサンプルサイズを決定することが可能なはずである。

つまり,サンプルサイズの検討をせずに研究を開始したのが,そもそもの間違いだった。データを得てしまった後でできるのは,次のような言い訳を書くことだけである。

こういう研究であっても,結果は将来のメタアナリシスに貢献するし,査読を通ることは時々ある。しかし,本当は,事前の計算から必要なサンプルサイズはこれくらいと予想されるけれども,稀な疾患なので期間内に研究対象とできる患者数はこれくらいと予想されるため,これだけの患者が集まったら分析する,と事前にデザインしておき,研究ノートあるいは短報の形で投稿すべきであろう26。

最近の医学統計のテキストをみると,サンプルサイズが小さすぎる研究は,価値のある相関や差を示すのに十分な検出力をもっていないので非倫理的であるし,サンプルサイズが大きすぎる研究も,研究対象者に対して,既に劣っていることが明らかになっている治療(処置)を受けさせる可能性があるので,同様に非倫理的であると書かれている。

多くの学術雑誌が今では査読のチェックリストをもっていて,その中には,方法のセクションにサンプルサイズを決定する過程が含まれているかどうかについての項目が入っているし,サンプルサイズの決定が研究の前に行われていて,事後的になされたのではないことを確認するように書かれていることが多い。

有名な学術雑誌の一つである英国医学雑誌(British Medical Journal)に,Altmanらが2000年に示した統計学ガイドラインでは,“Authors should include information on … the number of subjects studied and why that number of subjects was used.”(著者は,……研究対象者の人数と,どうしてその対象者数が用いられたのかについての情報を論文中に含めるべきである)と書かれている。

しかし,テキストの中には,サンプルサイズを計算しなくてよい,という言説もある。以下のような理由付けが与えられている。

質的研究やケースレポート,あるいは予備的研究やパイロットスタディでは,統計学的な検定や推定をしない場合があって,そういう研究ではサンプルサイズの計算は不要である。

記述的な研究では,測定値についての事前情報が存在しないのが普通であるため,サンプルサイズの計算が不可能なことも多い(通常,サンプルサイズ計算には,測定値の標準偏差が必要)。

実験研究の場合,経験則として,各群12個体という目安はある(3個体とか6個体にする場合もある。動物実験では純系の動物が使われるため,遺伝的多様性による個体差は無視できることが多く,比較的ばらつきが小さいからである)。主な要因によるクロス集計表を考え,セル(条件の組合せ)ごとの個体数が十分大きくなるような総個体数を確保せねばならない。

研究には,大別すると2つのタイプがある。既に説明したように,仮説検証では,研究前にサンプルサイズを計算することは常に必要である。

しかし,隠れた仮説を見つけ出したり,95%信頼区間を推定する記述的研究では,事前のサンプルサイズの計算は必ずしも要求されない。しかし,その場合は,サンプリングの適切性を評価するためのパワーアナリシス(検出力分析)を事後に実施することは可能である。

記述的研究では,小標本からの有病割合の推定は精度が低いか,ミスリーディングになることがある。例えば,有病割合を求めたいとき。20人を調べて2人が病気だった場合,有病割合は10%となるけれども,この10%は信頼性が低い。病気の人が1人増減しただけで,有病割合が5%も変わってしまう。サンプルサイズの計算をすることにより,十分に狭い信頼区間を得るためには何人調べれば良いかがわかる。

計算に必要な値は先行研究から得る。

ある狭さの信頼区間をもった平均値を推定するためのサンプルサイズを決定するのに必要な情報は次の3つである。

このとき,必要なサンプルサイズ(n)は次の式で得られる(ただし,qnorm(1− α/2)は,正規分布の1 − α/2パーセント点を意味する。通常,95%信頼区間を求めるには,97.5%点が必要になることに注意)。

n = qnorm(1− α/2)2 × 4 × SD2 / d2

(例)ある患者群において,収縮期血圧の平均値を,95%信頼区間が10 mmHgまたは5 mmHgに収まるように推定したいとする。先行研究から,標準偏差としては11.4 mmHgを使うことが妥当と考えられたとする。

95%信頼区間が10 mmHg幅でよければ, n = 1.962 × 4 × 11.42/102 = 19.97... = 20

しかし95%信頼区間を5 mmHg幅に収めたければ, n = 1.962 × 4 × 11.42/52 = 79.88... = 80

つまり,精度を2倍にするには,サンプルサイズを4倍にする必要がある。

次に,割合を推定する場合を示す。必要な情報は先行研究と割合を推定する目的から決まる,次の3つである。

必要なサンプルサイズを推定するための近似式は, n = qnorm(1− α/2)2 × 4 × p × (1−p) / d2

(例)成人集団における喘息の有病割合を,95%信頼区間が10%幅に収まるように推定したいとする。母集団における喘息の有病割合が10%とすると,p = 0.1,d = 0.1,α = 0.05なので,

n = 1.962 × 4 × 0.1 × (1 − 0.1)/0.12 = 1.962 × 36 = 138

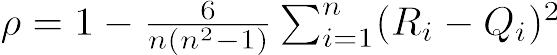

仮説検定においてサンプルサイズの計算に必要な情報は,次の5種類である。

検定方法ごとに(もっといえば,どれも近似式なので教科書あるいはソフトウェアによっても)推定式は異なっている。

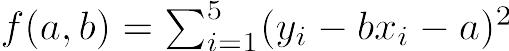

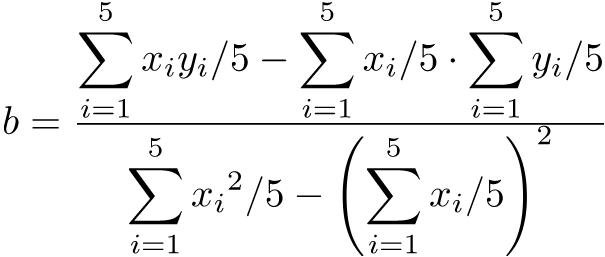

例えば,両側t検定で平均値を比べるときは,推定される標準偏差をSD,意味のある差をdとして(zαは正規分布の100αパーセント点を意味する。片側ならzα/2のところがzαとなる), n = 2 × (zα/2 − z1-β)2 × SD2/d2 + zα/22/4

カイ二乗検定で2つの標本比率の差を比べるときは,2つの集団において期待される比率をp1,p2として, n = (zα/2 − z1 − β)2 × {p1(1 − p1) + p2(1 − p2)}/(p1 − p2)2

これらはまったく異なる式であることが一目瞭然である。式で手計算するよりも,サンプルサイズ計算に特化したソフト(nQuery,PASS,PSなど)あるいは,一般的な統計解析ソフト(SAS,SPSS,STATA,EZR,R等)を使う方が便利である。

リハビリ中の患者を2群に分けて,電気刺激をしたときに,しないときに比べて,肘の屈曲角が大きくなるかどうか,平均値の比較をしたい例を考える。

先行研究から,屈曲が4度大きくなれば臨床的に重要な意味があると考えられ,屈曲角の増加の標準偏差は5度と考えられたとする。

「肘の屈曲角の増加に差は無い」という帰無仮説に対して有意水準5%,検出力90%の片側t検定をするために必要なサンプルサイズは, n = 2 × ( − 1.64 − 1.28)2 × 52/42 + ( − 1.64)2/4 = 27.3174

この結果から,各群28人いれば十分と考えられる(四捨五入でなく,それを上回る最小の人数であるべきなので,切り上げにすることに注意)。

実際には,諸事情により研究に参加した患者は,各群28人にはわずかに足りなかった。それでも,26人の患者に電気刺激をし,25人の患者に電気刺激をせずに,屈曲角の増加を測定したところ,彼らの屈曲角の増加は,それぞれ,16 ± 4.5と6.5 ± 3.4であった。2群の平均的な差は9.5 (95%CIは7.23から11.73)で,片側t検定の結果は,t=8.43, df=49, p < 0.001となり,有意水準5%で統計学的に有意な差があったといえる。

Methodsセクションには以下のように書き,

We designed the study to have 90% power to detect a 4-degree difference between the groups in the increased range of elbow flexion. Alpha was set at 0.05.

Resultsセクションには

Patients receiving electrical stimulation (n=26) increased their range of elbow flexion by a mean of 16 degrees with a standard deviation of 4.5, whereas patients in the control group (n=25) increased their range of flexion by a mean of only 6.5 degrees with a standard deviation of 3.4. This 9.5-degree difference between means was statistically significant (95%CI = 7.23 to 11.73 degrees; one-sided Student’s t test, t=8.43; df=49; p < 0.001).

のように書く(出典は2つの例文とも,Lang and Secic, 2006, pp.47;一部改変)28。

この英文には,期待される屈曲角の増加の標準偏差が5度であることや,計算に使われた式は書かれていない。ともに暗黙のうちに想定されるのが普通である。通常,計算に使ったソフトウェアとオプション指定を書いておけば,使った計算式も決まるので,式そのものを論文に書く必要は無い。

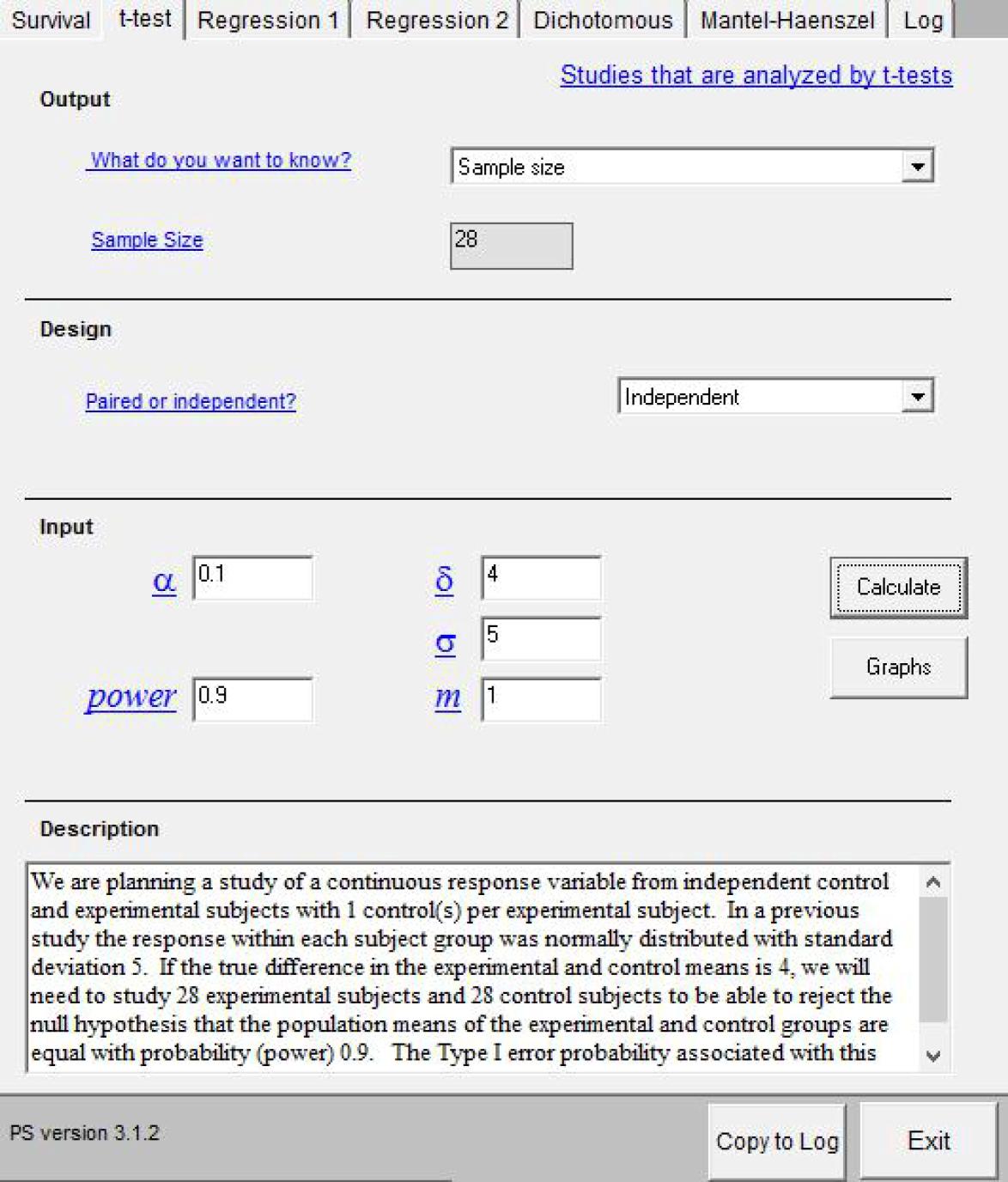

PS: Power and Sample Size Calculatorは,ヴァンダービルト大学で開発,公開されている,サンプルサイズの計算に特化したフリーソフトである。

https://biostat.app.vumc.org/wiki/Main/PowerSampleSizeからダウンロードできる。内蔵されている統計解析方法は,Survival (logrank test), t-test, Regression1, Regression2, Dichotomous (chisq-test), Mantel-Haenszelである。

特徴として挙げられるのは,サンプルサイズの計算を示す例文がテキストとして自動生成されることである29。なお,このソフトで指定できるオプションには,実験群と対照群のサイズの比(m)も含まれている。mは1にすることもあるが,2とか3にすることも珍しくない。

先に示した例でサンプルサイズを計算するには,PSを起動後,検定手法を選ぶタブの中からt-testを選び,求めるものはSample Size,サンプルの独立性はIndependentという順番で選び,δに4,σに5,αに0.1(片側5%なのだが,PSには片側検定の場合がないので両側10%で計算する),検出力に0.9,mに1と入力してから,「Calculate」ボタンをクリックすると,必要サンプルサイズが28と計算され,例文も自動生成される(下図)。

「統計解析」「必要サンプルサイズの計算」から条件を選ぶだけで完了する。この例では,メニューに表示される「2群の平均値の比較のためのサンプルサイズの計算」を選んで,下図のように,「2群間の平均値の差」のテキストボックスに4,「2群共通の標準偏差(SD)」のテキストボックスに5,「αエラー (0.0-1.0)」のテキストボックスに0.05,「検出力(1-βエラー)(0.0-1.0)」のテキストボックスに0.9,「グループ1と2のサンプルサイズの比(1:X)」のテキストボックスに1と入力し,解析方法のラジオボタンをOne-sidedにして「OK」ボタンをクリックすると,出力ウィンドウに各群27人という結果が得られる(One-sidedのところが両側ならば33人となる)。

> power.t.test(delta=4, sd=5, sig.level=0.05, power=0.9, alt="one.sided")

Two-sample t test power calculation

n = 27.46584

delta = 4

sd = 5

sig.level = 0.05

power = 0.9

alternative = one.sided

NOTE: n is number in *each* groupよって,必要なサンプルサイズは,各群28人となる。

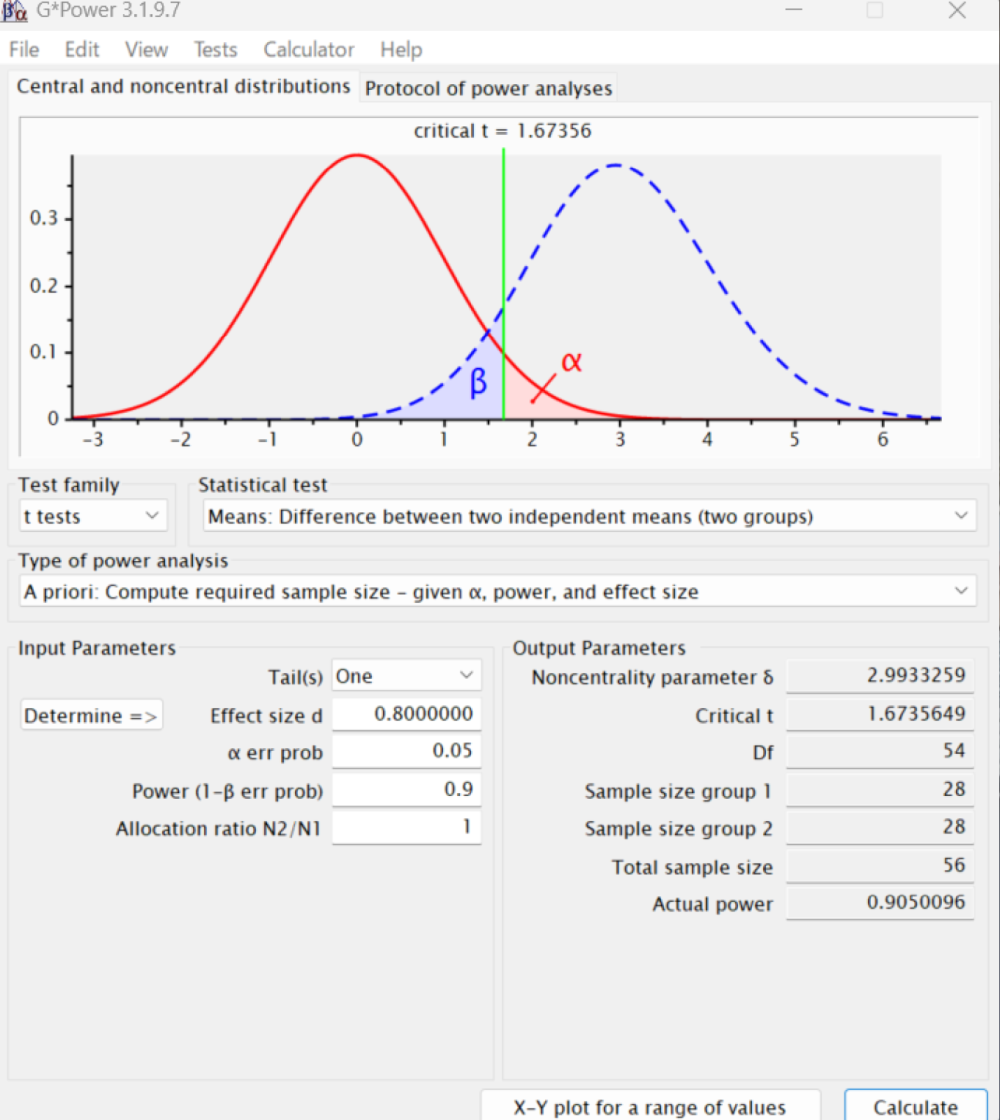

サンプルサイズや検出力の計算専用のソフトとして、上述のPSは最近更新されていないので、G*Powerというソフトも便利である。ドイツのキール大学のFranz Faulによって開発されたソフトだが、多くの人が共同で維持管理しており、最新版は3.1.9.7である(マニュアルや本体がここからダウンロードできる)。ここで取り上げられている例をG*Powerで実行するには、起動後に、TestsというメニューのMeansからTwo Independent Groupsを選択し、Type of power analysisというメニューがA priori Compute required sample size - given α, power, and effect sizeとなっているのを確認し、Tail(s)というメニューでOneを選択する。

次にEffect size dを入力しなくてはいけないのだが不明なので、それを計算するために、その行の左側に表示されているDetermineというボタンをクリックする。すると、効果量を計算するためのダイアログが開く。この場合、平均値の差が4、標準偏差が2群とも5と考えられるので、Mean group 1に0、Mean group 2に4、SD σ group 1に5、SD σ group 2に5と打って、左下のCalculateというボタンをクリックする。Effect size dとして0.8と表示されるので、それを元のウィンドウのEffect size dの枠に手入力しても良いし、Calculate and transfer to main windowというボタンをクリックすると自動入力される。

α err probには想定している検定の有意水準0.05、Power (1-β err prob)には想定している検出力0.9、Allocation ratio N2/N1には2群のサンプルサイズの比1を入力し、右下のCalculateというボタンをクリックすると結果が得られる。下図に示すように、Sample size group 1、Sample size group 2とも28となっている。

G*Powerでは、PSやEZRではサポートされていない、ロジスティック回帰分析のために必要なサンプルサイズの計算などもサポートされているので、使いこなせるようになると便利と思われる。

jamovi本体には入っていないが、jpowerモジュールやPAMLjモジュールを追加インストールすれば、jamoviでもサンプルサイズの計算は可能である。いずれも分析メニューのPowerというアイコンをクリックするとメニュー項目が表示される。独立2群間のt検定については、jpowerモジュールがIndependent Samples T-Testメニュー、PAMLjモジュールではT-testメニューを選ぶ。どちらの場合でも、G*Powerと同様に、意味がある(検出したい)平均値の差と期待される標準偏差ではなく、検出したい効果量を指定する。独立2群間のt検定での効果量は、平均値の差を標準偏差で割れば良い(2群に期待される標準偏差が異なる場合は、それらの2乗平均の平方根を求めて、2群共通の標準偏差として用いる)ので、この例では4/5で0.8を指定する。jpowerモジュールではMinimally-interesting effect size (δ)がデフォルトでは0.5となっているのを0.8に変えれば良い。Minimum desired powerはデフォルトが0.9なので、そのままで良い。α (type I error rate)もデフォルトが0.05なので、そのままで良い。Tailsをone-tailed (consistent)に変えれば、右側のウィンドウにN1とN2とも28と計算結果が表示される。PAMLjも指定方法は同様だが、得られる結果は2群を合計した56と表示される。PAMLjでは一般化線形モデルや構造方程式モデリングを当てはめるためのサンプルサイズの計算もサポートされている。

既に説明したとおり,研究には,大別すると,研究者が条件を設定しない研究(観察研究)と条件を設定する研究(実験研究や介入研究)がある。観察研究には,現状の記述を目的とする記述的研究と,仮説検証型の研究がある。

実験的研究では,動物実験でも臨床試験でも,研究者が条件設定できるので,注意深くデザインされねばならない。実験研究のデザインは,実験計画法として発展してきた。

実験計画法は,R.A. Fisherがロザムステッドで行った農学研究に始まるが,保健医療分野では,この種のデザインは,毒性試験や臨床試験で用量反応関係を分析するために必須である。もちろん,ヒトを対象にした研究は,実施前に倫理審査を通らねばならず,倫理審査に提出する書類には,適切なサンプルサイズの設定を含む,適切な研究デザインが記述されねばならない。

ケンブリッジのある晴れた日,多くの教授がアフタヌーンティーを楽しんでいた。と,ある婦人が,自分はミルクティーを飲めば,それがミルクが先か紅茶が先のどちらで淹れたものか判定できると主張した。世間一般の普通の人々は,そんなのどうでもいいじゃないかと思うかもしれないが,大学教授という人種は,そういうことに拘ることを生きがいにしている人が普通である。その場にいた教授たちの間で,当然のように,彼女の主張を廻って大激論が勃発した。先行研究があるわけでもなく,当然,収拾がつかない。

そこでR.A. Fisherが,「実験したらどうだい?」と言った。Fisherがいうには,この能力は,ミルクを先に入れて作ったミルクティーと紅茶を先に淹れて作ったミルクティーを何杯か用意して,無作為な順番で飲んで貰えば,確率論的に,どれくらい偶然ではありそうもないことかを判定できるというのだ。ここで大事なことは,能力の判定条件を考える必要があるということと,何回の繰り返しが必要かということだ。それを体系化した考え方が,上記3原則を含む実験計画法だというのである。

これは,「本当かどうかはわからないが」との注釈つきで,David Salsburgという人が,20世紀において,どのようにあらゆる科学に統計学が影響を与えてきたかについて書いた,“The lady tasting tea.”に掲載されているエピソードである。

ミルクティーの味の話がでてきたので,ここでちょっと余談。ロシア革命の混乱を風刺した小説『動物農場』や管理社会のディストピア小説として知られる『1984年』の作者であるジョージ・オーウェルは,無類の紅茶好きであり,「完璧な紅茶を淹れる11の法則」(Perfect Cuppa)30を次のように書いている(ストレートのダージリンに代表される,普通の「おいしい紅茶」の淹れ方とは随分違うが)。

George Orwell 「完璧な紅茶を淹れる11の法則」 (Perfect cuppa)

しかし,英国の王立化学会がGeorge Orwellの生誕100年を記念するパーティを開いたとき,Dr. Andrew Stapley (2003)は,次のように述べた。「冷えたミルクをカップの底に入れておいてから,熱い紅茶を注ぐのが良い。こうするとミルクが紅茶を冷ますことができる。逆だと熱い紅茶がミルクの温度を急に上げるのでミルクの風味が損なわれる」31。オーウェル推奨の順番は間違っているというわけである。

本当はどちらが先だとより美味しいのか,試してみた日本人ブロガーがいた。130ccの紅茶と30ccのタカナシ低温殺菌牛乳を使用した(高温殺菌とかロングライフのミルクでは違いが分からないらしい)。この方の主観的判断では,「ミルクが先」が美味だったとのことである32。

1杯ずつ増やして確率計算をしてみよう。

というわけで,本当は判別能力が無いのに偶然5回連続で正解する確率が,3.125% とわかる。この値は,偶然で片付けるには稀すぎる。通常,この判定基準は5%を切るかどうかにおく。これが有意水準(Fisher流)である。5回とも正しく判定されれば,帰無仮説「彼女は判定能力をもっていない」が有意水準5%で棄却される。

つまり,この仮説の統計学的検定には,少なくとも5杯のミルクティーを飲む必要がある。

実験計画法には,目的に応じて様々なデザインがある。有名なデザインをいくつか列挙しておく。

このデザインを使うと,研究者は,個々の対象者に対して同じ精度で測定された,何かの処理の前後で測定値に変化がないかどうかを評価することができる。通常使われる検定手法は,対応のあるt検定や,ウィルコクソンの符号順位検定になる。なお,対応のあるt検定は,個人ごとに算出した変化量の平均値がゼロという帰無仮説を検定する一標本t検定と,数学的には同値である。以下のような研究が典型的な例である。

EZRでの対応のあるt検定の実行例

EZRで,対応のあるt検定を実行する例を示す。対応のあるt検定自体は,事前-事後デザインに限らず,同一対象者に対して同じ精度で測定した値があれば適用可能なので,ここでは,Rには標準で含まれているMASSパッケージの,surveyデータフレームの,左右の手の大きさを比べる例を示す(このデータはアデレード大学で統計学を受講している学生237人に対する質問紙による横断的研究で得られた値であり,事前-事後デザインではない。出典:Venables and Ripley, 1999)。

このデータに含まれる変数のうち,Wr.Hndは,字を書く方の手を広げたときの大きさ,即ち親指の先端と小指の先端の距離であり,NW.Hndは,反対側の手を広げたときの大きさである。

EZRでの手順としては,まずデータをアクティブにする。「ツール」の「パッケージの読み込み」でMASSを選んでから,「ファイル」の「パッケージに含まれるデータを読み込む」から,パッケージとしてMASSをダブルクリックし,データフレームとしてsurveyをダブルクリックして「OK」ボタンをクリックすればよい。

次に,「統計解析」「連続変数の解析」から「対応のある2群間の平均値の比較(paired t検定)」を選ぶ。第1の変数としてWr.Hnd,第2の変数としてNW.Hndを選び(逆でも良い),「OK」ボタンをクリックすると,下枠内の結果が表示される。文字を書く手の方が,反対側の手よりも平均して0.086cm大きく,この差は統計学的に有意水準5%で有意であるとわかる。

Paired t-test

data: survey$Wr.Hnd and survey$NW.Hnd

t = 2.1268, df = 235, p-value = 0.03448

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

0.006367389 0.166513967

sample estimates:

mean of the differences

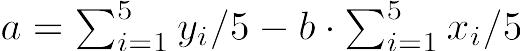

0.08644068既に述べたように,対応のあるt検定は差の平均がゼロという一標本t検定と数学的にまったく同じである。数式でも簡単に説明しておく,サンプルサイズnの標本のi番目の人について,対応のある2つの変数XとYの値をXi,Yiと書けば,XとYに差がないという帰無仮説は,Zi = Xi − Yiとして計算される「差の変数」Zの標本平均が母平均0と差がないという帰無仮説に帰着する。このとき,検定統計量t0は, として,

として,  が自由度n − 1のt分布に従うことを使って検定できる。

が自由度n − 1のt分布に従うことを使って検定できる。

練習問題

珈琲を飲む前後で,計算問題の得点が変わるかどうか比べる。EZRでは,まずデータを作る。「ファイル」「新しいデータ」を選んでデータセット名を入力し(例えばcoffeeなどと名付ける),表計算のようなウィンドウでデータを入力する(1列目に珈琲を飲む前の得点を入力し,2列目に飲んだ後の得点を入力する)。各列の変数名の部分をクリックすると,変数名を入力したり,型が数値(numeric)か文字(character)かを指定することができる。

または,コンソールに

> scores <- data.frame(

+ precoffee=c(6, 5, 7, 6, 6, 7, 4, 5, 6, 7),

+ postcoffee=c(7, 8, 6, 7, 7, 8, 5, 6, 7, 7))と入力してもよい。

EZRの「統計解析」から「連続変数の解析」「対応のある2群間の平均値の比較(paired t検定)」と選んで,第1の変数としてprecoffee,第2の変数としてpostcoffeeを選べば,[t = -2.862, df = 9, p-value = 0.01872]と結果が出る。有意水準5%で統計学的に有意な差があるといえる。

これは非常に単純である。研究参加に同意した対象者各人に対して,完全にランダムに(行き当たりばったりに,ではなく),いくつかの処理(曝露)の1つを割り付け,処理間での比較をするというものである。

無作為化(randomization)の方法にはいくつかある。Fleiss JL (1986)“The design and analysis of clinical experiments”は,乱数表(random number table)の代わりに乱数順列表(random permutation table)を使うことを推奨している。

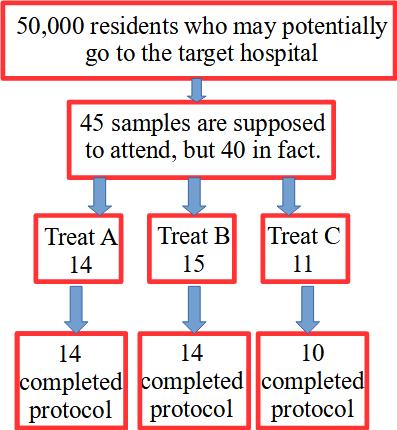

しかし,今ではコンピュータソフトが使えるので,紙の表を使わなくても,簡単にランダム割り付けはできる。Rの場合だと,例えば45人の対象者に対して3種類の処理を割り付けたいなら,次のようにする。

> matrix(sample(1:45, 45, replace=FALSE), 3)このままだと数字の出現順がバラバラで見にくいので,いったんxというオブジェクトに結果を付値して,それを行方向に小さい順に並べ替えて表示させるには以下のようにする。

> x <- matrix(sample(1:45, 45, replace=FALSE), 3)

> x[1,]

[1] 31 34 23 5 17 44 27 14 7 30 16 1 33 4 19

> apply(x, 1, sort)

[,1] [,2] [,3]

[1,] 1 2 8

[2,] 4 3 10

[3,] 5 6 11

[4,] 7 9 12

[5,] 14 13 20

[6,] 16 15 21

[7,] 17 18 22

[8,] 19 24 26

[9,] 23 25 28

[10,] 27 29 35

[11,] 30 32 39

[12,] 31 36 41

[13,] 33 37 42

[14,] 34 38 43

[15,] 44 40 45しかし,実際の研究では脱落が起こったりして,予定の人数に満たない場合がある。上の例でも,40人しか対象者が集まらないと,第2の処理を受ける人は15人いるが,第1の処理を受ける人は14人,第3の処理を受ける人はたった11人になってしまい,サンプルサイズがアンバランスになって検出力が落ちる。

このデザインによる研究の流れを下図に示す。このダイアグラムでは,研究対象者から得られる量的なデータを一元配置分散分析(oneway ANOVA)で分析し,割合のデータをカイ二乗検定で分析する。

何らかの事情で研究が完了しない場合,完全無作為化法では,既に述べたようにグループ間のサンプルサイズがアンバランスになる可能性がある。

この欠点を克服するのが乱塊法である。上述の例では,3種類の処理を15人ずつに適用する。3種類の処理を実施する順番は6通りなので33,1人ずつランダムに選ぶ代わりに,この6通りのブロックをランダムに15回選べば良いと考えられる。

そうすることによって,もし研究が途中で終わってしまっても,群間のサンプルサイズの差は最大1に抑えられる。記述と分析は完全無作為化法と基本的に同じだが,ブロックの効果を考慮した分析も可能である。

サイズバランスを保つ方法はもう一つあり,「最小化法」と呼ばれる。サンプリング時点ごとに群間のサンプルサイズの違いが最小になるような制約条件のもとでランダム割り付けを行う(あまりお薦めしない)。

2×2の要因配置法の例を示す。McMasterら (1985)は,乳がんの自己触診の教材としての小冊子とテープ/スライドを評価する無作為化試験を実施した。2種類の教材があるので,2×2の組合せで,4種類の平行群間試験としての実験をデザインできる。即ち,

このデザインでは,2種類の教材の教育効果は二元配置分散分析(Two-way ANOVA)を使って評価できる。

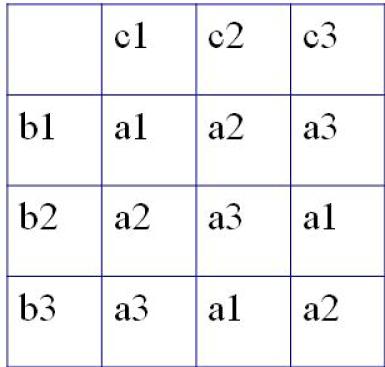

実験において,2つ以上の水準pがある処理Aの効果を評価したいとき,ともに同じ水準数pをもつ交絡因子BとCの影響を調整する必要がある場合に,このデザインが有効である。ラテン方格という名前は古代のパズルに起源がある。

ここではpが3であると仮定して説明する。ラテン方格は下図のようになる。最初のグループとしては,n1人の対象者について,a1b1c1という組合せの処理を行う。次のn2人は,グループ2として,a1b2c3という処理を受ける。残りも同じように図示した順番で処理を行う。そうすれば,アウトカム変数に対するBとCの効果を,分散分析(ANOVA)によって調整(除去)して,要因Aの効果を評価することができる(デザインの工夫によってBとCの効果は打ち消せると期待されるので,ターゲットであるAの効果だけを一元配置分散分析すれば良くなる)。

クロスオーバー法では,それぞれの対象者が2種類の処理を受ける。このとき,適当な間隔(ウォッシュアウト期間と呼ぶ。前の処理の影響のキャリーオーバーを避けるために設ける)をおくことと,処理の順番が違う2つのグループを設定することが必要である。

Hilman BC et al. “Intracutaneous immune serum globulin therapy in allergic children.”, JAMA. 1969; 207(5): 902-906.を例として説明しよう。

この研究では,同意が得られた574人から,まず研究目的に対して不適格な43人を除外し,531人をランダムに2群に分けた。グループ1が266人,グループ2が265人となった。グループ1に処理Aを行い,34人が脱落した。同時にグループ2には処理Bを行い,脱落が15人であった。その後,2ヶ月のウォッシュアウト期間をおき,グループ2の250人に処理Aを,グループ1の232人に処理Bを行ったところ,それぞれ45人,29人が脱落したので,2回の処理を完了したのは合計408人となった。

統計解析は,プレテストとして(1)キャリーオーバー効果が無視できるか検定(2群それぞれの2つの測定値の和の平均値の差の検定),それが確認できたら,(2)2群それぞれの差の平均値の差の検定,と実施すると良い(参考:Wellek S, Blettner M: Dtsch Arztebl Int. Apr 2012; 109(15): 276-281. doi: 10.3238/arztebl.2012.027634)

週刊医学界新聞の記事35が大変参考になるので読まれたい。

臨床試験を含む実験研究では,アウトカム(結果)の評価にいくつかのタイプがあり,それぞれ検定すべき帰無仮説が異なるため,サンプルサイズの設計法も異なる。

優性試験は,新しい処理群が対照群に比べて統計学的に有意に良い効果を示すかどうかを調べる。新薬の臨床試験などの場合に用いられる。「差がない」帰無仮説を検定して,p値が有意水準より小さければ帰無仮説を棄却する。

同等性試験は,新しい処理群が対照群と同じような効果を示すかどうかを調べる。検定でなく,「十分なサンプルサイズ」で正確に同等だというために信頼区間を用いる。事前に決めた「±○×%の差であれば臨床的に同等」とみなす同等性の許容範囲(同等性マージン,研究計画書にも記載)内なら同等とみなす。

非劣性試験は同等性試験の特殊な場合で,新しい処理が対照群に比べて劣っていないことを示せばいいとき,信頼区間を片側にすることでサンプルサイズを節約できるというアイディアに基づく。例えば,安価なジェネリック医薬品が従来薬に比べて薬効が劣っていなければいいという場合が典型的である。

実験計画法に基づく研究結果は,これまで書いてきたとおり,p値と帰無仮説の棄却,あるいは,差の信頼区間で示すのが普通である。しかし,1994年にCohenが“The earth is round (p < .05)”という論文を書いて有意水準批判をしたことから,アメリカ心理学会(APA)の推測統計に関する専門委員会が,統計解析の結果を報告する際のガイドラインを検討し,1999年に発表された提案において,信頼区間を使用した区間推定を示すことに加えて,重要な知見あるいはp値を報告するときは必ず効果量を報告することを含めたことから,心理学分野では統計改革が起こった。

APA Publication Manual 6th Edition (2009)では,具体的に,信頼区間をブラケットで示すことや,p値の後に効果量を記載することがAPAが発行する論文誌では最低限の要求であると書かれている。統計改革の流れは他分野にも波及したが,医学・保健学では信頼区間の重要性が強調され,生態学などフィールド生物学では統制が難しくサンプルサイズが小さいことが多いため検定力についての記載が求められることが多いので,効果量を記載することが必須になったのは,現状では,心理学分野と,質問紙調査で心理的尺度を用いる教育学や社会調査,疫学の一部にほぼ限られている36。

大久保・岡田(2012)による効果量(effect size)の定義は,「効果の大きさをあらわす統計的な指標のこと」で,「p値や検定統計量とは異なり,帰無仮説が正しくない程度を量的に表す指標」で,「帰無仮説が完全に正しい場合,一般に効果量は0,帰無仮説が正しくない場合は,正しくない程度が大きいほど効果量の絶対値も大きくなる」とのことである。仮説検定で帰無仮説が棄却できなくても効果量が0とは限らない点に注意が必要である。

一般に,検定統計量はサンプルサイズの関数と効果量の関数の積として表されることから,サンプルサイズが同じなら,効果量が大きいほど検定統計量は大きくなり,p値が小さくなることと,効果量が同じならば,サンプルサイズが大きいほど検定統計量が大きくなりp値が小さくなることが言える。サンプルサイズが大きくなると,ほとんど無視できるほど小さい効果量であっても,p値が0.05より小さくなることは普通にありうるので,数万人以上のサンプルサイズで有意水準を5%にした仮説検定などしても,実際的な意味はない。

効果量はサンプルサイズに依存しない(検定統計量からサンプルサイズに依存する部分を除去したものが効果量であるともいえる)のは,重要な性質である。以下,典型的な効果量をいくつか示す。

群間差についての効果量をd族の効果量と呼ぶ。三重大学奥村教授の解説37が参考になるが,2群間の平均値の差についてのCohenのdとHedgesのgが有名である。

Cohenのdは,標本の平均値の差を,標本のプールした標準偏差38で割って得られる,記述的な効果量である。言い換えると,2群の平均値の差が,プールした標準偏差の何倍かという値がCohenのdである。Hedgesのgは,Cohenのdを求める式において,標本のプールした標準偏差の代わりに,2群に共通な母分散を標本から推定する際の不偏推定量39を用いて得られる値である。spは不偏推定量ではないため,gも不偏推定量とはならないが,母標準偏差との差はspの方がSpよりも小さいことが知られているので,gの方がdより推奨されている。2群のサンプルサイズが等しい場合は,gに補正係数を掛けることによって得られる,バイアス補正したg(δ̂)を用いることもできる。補正係数J(n1 + n2 − 2)は次の式で得られる。

Hedges(1981)はJ(n1 + n2 − 2)の近似式として を提案している。

を提案している。

Rでは,effsizeパッケージのcohen.d()関数で,2群の値を示すベクトルをコンマで区切って与えるか,量の変数を第1引数,群の変数を第2引数としてコンマで区切って与えるかすれば,CohenのdまたはHedgesのgが得られ(後者が欲しいときはオプションとしてhedges.correction=TRUEを指定する),それらの効果量の信頼区間も得られ,効果量の大きさの目安として,絶対値が0.2未満だと無視できる(negligible),0.2以上0.5未満だと小さい(small),0.5以上0.8未満だと中程度(medium),0.8以上だと大きい(large)という判定を表示してくれて便利である。ただし,cohen.d()がCohen’s dとして表示するのは大久保・岡田(2012)でいうHedgesのgであり,Hedges’s gとして表示されるのがバイアス補正されたHedgesのgであることに注意されたい。

https://minato.sip21c.org/ebhc/dfamefs.R

dfamefs <- function(G1, G2) {

varp <- function(X) { sum((X-mean(X))^2)/length(X) }

J <- function(alpha) {

gamma(alpha/2)/(sqrt(alpha/2)*gamma((alpha-1)/2)) }

n1 <- length(G1)

n2 <- length(G2)

Sp <- sqrt((n1*varp(G1)+n2*varp(G2))/(n1+n2))

# Sp2 <- sqrt((n1*var(G1)+n2*var(G2))/(n1+n2))

# Sp3 <- sqrt(((n1-1)*(sd(G1)^2)+(n2-1)*(sd(G2)^2))/(n1+n2))

d <- (mean(G1)-mean(G2))/Sp

# d2 <- (mean(G1)-mean(G2))/Sp2

# d3 <- (mean(G1)-mean(G2))/Sp3

sp <- sqrt(((n1-1)*var(G1)+(n2-1)*var(G2))/(n1+n2-2))

g <- (mean(G1)-mean(G2))/sp

gadj <- g*(1-3/(4*(n1+n2)-9))

gadj2 <- g*J(n1+n2-2)

delta <- (mean(G1)-mean(G2))/sd(G2) # G2 has to be control

deltaadj <- (1-3/(4*length(G2)-5))*delta

return(list(Cohend=d, Hedgesg=g, gadj=gadj, gadjexaxt=gadj2,

Glassdelta=delta, deltaadj=deltaadj))

}

library(effsize)

G1 <- sleep$extra[sleep$group==1]

G2 <- sleep$extra[sleep$group==2]

cohen.d(G1, G2)

# cohen.d(sleep$extra, sleep$group)

cohen.d(G1, G2, hedges.correction=TRUE)

# cohen.d(sleep$extra, sleep$group, hedges.correction=TRUE)

dfamefs(G1, G2)

# Okubo, Okada (2012) Table 3.4

Exp <- c(59, 48, 51, 41, 39, 84, 95, 56, 86, 74)

Ctl <- c(47, 24, 38, 28, 39, 74, 77, 48, 40, 60)

cohen.d(Exp, Ctl)

cohen.d(Exp, Ctl, hedges.correction=TRUE)

dfamefs(Exp, Ctl)

}結果は以下の通り。

> cohen.d(G1, G2)

Cohen's d

d estimate: -0.8321811 (large)

95 percent confidence interval:

lower upper

-1.8115649 0.1472027

> cohen.d(G1, G2, hedges.correction=TRUE)

Hedges's g

g estimate: -0.7970185 (medium)

95 percent confidence interval:

lower upper

-1.7731697 0.1791327

> dfamefs(G1, G2)

$Cohend

[1] -0.8771959

$Hedgesg

[1] -0.8321811

$gadj

[1] -0.7970185

$gadjexaxt

[1] -0.7969352

$Glassdelta

[1] -0.7891127

$deltaadj

[1] -0.7214745> # Okubo, Okada (2012) Table 3.4

> Exp <- c(59, 48, 51, 41, 39, 84, 95, 56, 86, 74)

> Ctl <- c(47, 24, 38, 28, 39, 74, 77, 48, 40, 60)

>

> cohen.d(Exp, Ctl)

Cohen's d

d estimate: 0.8321811 (large)

95 percent confidence interval:

lower upper

-0.1472027 1.8115649

> cohen.d(Exp, Ctl, hedges.correction=TRUE)

Hedges's g

g estimate: 0.7970185 (medium)

95 percent confidence interval:

lower upper

-0.1791327 1.7731697

> dfamefs(Exp, Ctl)

$Cohend

[1] 0.8771959

$Hedgesg

[1] 0.8321811

$gadj

[1] 0.7970185

$gadjexaxt

[1] 0.7969352

$Glassdelta

[1] 0.8831702

$deltaadj

[1] 0.8074699変数間の関係の大きさを表す効果量をr族の効果量と呼ぶ。ピアソンの積率相関係数やポリシリアル相関係数,ポリコリック相関係数,回帰分析における決定係数,偏相関係数の二乗,分散分析におけるη2やηp2などは,すべてr族の効果量である。

研究によって得られたデータをコンピュータを使って統計的に分析するためには,まず,コンピュータにデータを入力する必要がある。データの規模や利用するソフトウェアによって,どういう入力方法が適当か(正しく入力でき,かつ効率が良いか)は異なってくる。

ごく小さな規模のデータについて単純な分析だけ行う場合,電卓で計算してもよいし,分析する手続きの中で直接数値を入れてしまってもよい。例えば,60 kg, 66 kg, 75 kgという3人の平均体重をRを使って求めるには,プロンプトに対してmean(c(60,66,75))または(60+66+75)/3と打てばいい。

しかし実際にはもっとサイズの大きなデータについて,いろいろな分析を行う場合が多いので,データ入力と分析は別々に行うのが普通である。そのためには,同じ調査を繰り返しするとか,きわめて大きなデータであるとかでなければ,Microsoft ExcelやLibreOffice Calcのような表計算ソフトで入力するのが手軽であろう。きわめて単純な例として,10人の対象者についての身長と体重のデータが次の表のように得られているとする。

| 対象者ID | 身長(cm) | 体重(kg) |

|---|---|---|

| 1 | 170 | 70 |

| 2 | 172 | 80 |

| 3 | 166 | 72 |

| 4 | 170 | 75 |

| 5 | 174 | 55 |

| 6 | 199 | 92 |

| 7 | 168 | 80 |

| 8 | 183 | 78 |

| 9 | 177 | 87 |

| 10 | 185 | 100 |

まずこれを表計算ソフトに入力する。一番上の行には変数名を入れる。日本語対応Rなら漢字やカタカナ,ひらがなも使えるが,半角英数字(半角ピリオドも使える)にしておくのが無難である。入力が終わったら,一旦,そのソフトの標準の形式で保存しておく(Excelならば*.xlsx形式,LibreOfficeのCalcならば*.ods形式)。

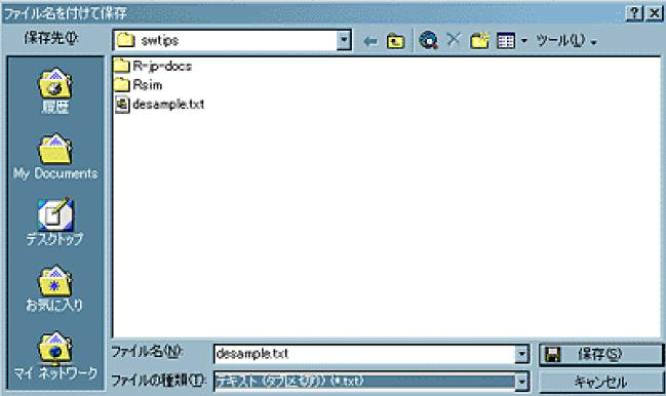

次に,この表をタブ区切りテキスト形式で保存する。Excelの場合は,メニューバーの「ファイル(F)」から「名前を付けて保存」を選び,現れるウィンドウの一番下の「ファイルの種類(T)」のプルダウンメニューから「テキスト(タブ区切り)(*.txt)」を選ぶと,自動的にその上の行のファイル名の拡張子もxlsxからtxtに変わるので,「保存 (S)」ボタンを押せばOKである(下のスクリーンショットを参照)40。複数のシートを含むブックの保存をサポートした形式でないとかいう警告が表示されるが無視して「はい」を選んでよい。その直後にExcelを終了しようとすると,何も変更していないのに「保存しますか」と聞く警告ウィンドウが現れるが,既に保存してあるので「いいえ」と答えてよい(「はい」を選んでも同じ内容が上書きされるだけであり問題はない)。この例では,desample.txtができる。

Rコンソールを使って,このデータをDatasetという名前のデータフレームに読み込むのは簡単で,次の1行を入力するだけでいい(ただしテキストファイルが保存されているディレクトリが作業ディレクトリになっていなくてはいけない)。

Dataset <- read.delim("desample.txt")

Rcmdrでのタブ区切りテキストデータの読み込みは,メニューバーの「データ」から「データのインポート」の「テキストファイルまたはクリップボードから」を開いて41,「データセット名を入力:」の欄に適当な参照名をつけ(変数名として使える文字列なら何でもよいのだが,デフォルトではDatasetとなっている),「フィールドの区切り記号」を「空白」から「タブ」に変えて(「タブ」の右にある○をクリックすればよい),OKボタンをクリックしてからデータファイルを選べばよい。

なお,データをファイル保存せず,Excel上で範囲を選択して「コピー」した直後であれば,「データのインポート」の「テキストファイル又はクリップボードから」を開いてデータセット名を付けた後,「クリップボードからデータを読み込む」の右のチェックボックスにチェックを入れておけば,(データファイルを選ばずに)OKボタンを押しただけでデータが読み込める。

Windows版では,R-2.9.0とRcmdr1.4-9以降なら,RODBCパッケージの機能によってExcelファイルを直接読み込むこともできる。「データ」の「データのインポート」の「from Excel, Access, or dBase dataset」を開いて42,「データセット名を入力:」の欄に適当な参照名をつけ,Excelファイルを開くとシートを選ぶウィンドウが出てくるので,データが入っているシートを選べば自動的に読み込める。

断面研究が典型的だが,1つの時点で多くの対象者から得たデータは,上述のように表形式にするのが容易である。複数のグループがあっても,グループを示すカテゴリ変数を作り,ともかく1人が1行に収まるようにすればよい。

コホート研究や繰り返し測定を含むデータの場合は,異なる時点で得たデータをどのように保持するかによって表の形が変わるため(あくまで1人を1行として入力する方が,後述する反復測定分散分析やフリードマンの検定をするには便利だし,1時点での測定値を1行とし,同じ人が複数行に出てくるように入力した方が作図や解析の目的次第では便利である),表形式にするよりもリレーショナルテータベースとしてデータベース構造を定義し,解析目的に応じてさまざまな表を出力できるようにした方が便利である。表計算ソフトを使う場合でも,時点ごとに別々のシートに入力すれば,ある程度この目的に対応できる。リレーショナルデータベースとしては,Microsoft OfficeならばAccess,LibreOfficeならばbaseとして含まれている。米国CDCが開発して無料で公開しているEpiInfoでは43,[Enter data]というメニューから,Access形式のデータベースを設計して入力・編集することができるようになっている。

経時的にとったデータの推移や,複数の時系列の相互作用を扱いたい場合は,データ構造が複雑になる。国によって暦法など時間情報を扱う単位が異なっていたり時差があったりするため,時間データベースが標準化されていて,時間情報解析ソフトというものも開発されている。HuTimeというソフト44は無料で利用できる。

地理情報もまた,表形式では扱いにくい情報である。バックグラウンドとなる地理情報と関連づけるためには,地理情報解析システム(GIS; Geographic Information System)を利用すると良い(詳細は非常勤でご出講いただく谷村先生の講義を参考にされたい)。高度な機能を使いたい場合はArcInfoというきわめて高価なソフトが標準的なソフトとして広まっているが,基本的な解析だけならば,QGIS45などのフリーソフトでも十分に実行できる。

なお,データ入力は,入力ミスを防ぐために,2人以上の人が同じデータを入力し,それを比較するプログラムを実行して誤りをチェックする方法がよいとされる。Excelのワークシートが2枚できたときに,それらを比較するには,1つのブックのSheet1とSheet2にそれらを貼り付けておき,Sheet3の一番左上のセル(A1)に,

=If(Sheet1!A1=Sheet2!A1,"","X")と入力し,これをコピーして,Sheet3上の全範囲(Sheet1とSheet2に参照されているデータがある範囲)に貼り付けると,誤りがあるセルにのみ"X"という文字が表示される。元データを参照してSheet1とSheet2の不一致部分をすべて正しく直し終われば,Sheet3が見かけ上空白になるはずである。

しかし,現実には2人の入力者を確保するのが困難なため,1人で2回入力して2人で入力する代わりにするか,あるいは1人で入力してプリントアウトした結果を元データと見比べてチェックするといった方法が使われることも多い。生データを自分で読み上げて録音し,再生音を聞きながら入力したデータをチェックする方法も,比較的効率は良い。

ここで注意しなければならないのは,欠損値の取扱いである。一般に,統計処理をする対象のデータは,母集団から標本抽出したサンプルについてのものである。サンプルデータを統計解析して,母集団についての情報を得るためには,そのサンプルが正しく母集団を代表していることが何より大切である。質問紙調査の場合でも,実験研究の場合でも,欠損値(質問紙なら無回答,非該当,わからない,等,実験研究なら検出限界以下,測定用の試料の量の不足,測定失敗等)をどのように扱うかによって,サンプルの代表性が歪められてしまうことがある。欠損が少なければあまり気にしなくていいが,たとえば,健診の際の食生活質問等で,「甘いものが好きですか」に対して無回答の人は,好きだけれどもそれが健康に悪いと判断されるだろうから答えたくない可能性があり,その人たちを分析から除くと,甘いもの好きの人の割合が,全体よりも少なめに偏った対象の分析になってしまう。なるべく欠損が少なくなるような努力をすべきだけれども,どうしても欠損のままに残ってしまった場合は,結果を解釈する際に注意する。

欠損値のコードは,通常,無回答(NA)と非該当と不十分な回答が区別できる形でコーディングするが,ソフトウェアの上で欠損値を欠損値として認識させるためのコードは,分析に使うソフトウェアによって異なっているので,それに合わせておくのも1つの方法である。デフォルトの欠損値記号は,RならNA,SASなら.(半角ピリオド)である。Excelではブランク(何も入力しない)にしておくと欠損値として扱われるが,入力段階で欠損値をブランクにしておくと,「入力し忘れたのか欠損値なのかが区別できない」という問題を生じるので,入力段階では決まった記号を入力しておいた方が良い。その上で,もし簡単な分析までExcelでするなら,すべての入力が完了してから,検索置換機能を使って(Excelなら「編集」の「置換」。「完全に同一なセルだけを検索する」にチェックを入れておく),欠損値記号をブランクに変換すれば用は足りる。

欠損コードの変更 実は欠損値を表すコードの方を変更することも可能である。例えばRではread.delim()などデータファイルを読み込む関数の中で,例えばna.string="-99"とオプション指定すれば,データファイル中の-99を欠損値として変換しながら読み込んでくれる。

次に問題になるのが,欠損値を含むデータをどう扱うかである。結果を解釈する上で一番紛れのない方法は,「1つでも無回答項目があったケースは分析対象から外す」ということである46(もちろん,非該当は欠損値ではあるが外してはならない)。その場合,統計ソフトに渡す前の段階で,そのケースのデータ全体(Excel上の1行)を削除してしまうのが簡単である(もちろん,元データは別名で保存しておいて,コピー上で行削除)。 質問紙調査の場合,たとえば100人を調査対象としてサンプリングして,調査できた人がそのうち80人で,無回答項目があった人が5人いたとすると,回収率(recovery rate)は80%(80/100)となり,有効回収率(effective recovery rate)が75%(75/100)となる。調査の信頼性を示す上で,これらの情報を明記することは重要である。目安としては有効回収率が80%程度は欲しい。

もう少し厳密に考えると,上述のごとくランダムでない欠損は補正のしようがないが,欠損がランダムな場合でも2通りの状況を分けて考える必要がある。即ち,MISSING COMPLETELY AT RANDOM (MCAR) の場合は単純に除去しても検出力が落ちるだけでバイアスはかからないが,MISSING AT RANDOM (MAR),つまり欠測となった人とそうでない人の間でその変数の分布には差が無いが他の変数の分布に差がある場合には,単純に除去してしまうとバイアスがかかるのである。そのため,multiple imputation(多重代入法)という欠損値を補う方法がいろいろ開発されている47。Rでは,mitools48とmice49という2つのパッケージがあり,後者のメインテナはDr. Stef van Buurenというオランダの方で,実はMultiple Imputation Onlineというサイト50のHeadをされている専門家である。ネット上の情報を眺めていると,たぶんmiceパッケージを使うのが良いと思われるが,まだ評価は定まっていないようである。最近ではAmeliaというパッケージがあり,高橋将宜・渡辺美智子『欠測データ処理:Rによる単一代入法と多重代入法』共立出版,ISBN978-4-320-11256-8で丁寧に使い方が紹介されている。

例えば,欠損のあるデータフレーム名をwithmissとすると,library(mice)の後で,imp <- mice(withmiss)とすると,元データやmultiple imputationによる欠損値推定の係数群がimpというオブジェクトに保存される。multiple imputationの方法は"sample","pmm","logreg","norm","lda","mean","polr"などから選べて,mice()関数のmeth=オプションで指定できる。欠損値が補完されたデータフレームを得るには,est <- complete(imp, 2)などとする。デフォルトでは5組の係数群が推定されるので,この例で指定した2により,そのうち2番目の係数群を使って推定されるデータフレームが得られる。あとは,このデータフレームを使って解析した複数の結果をまとめる必要がある。

無料で読める日本語による欠損値処理の説明としては,覚え書きとのことだが,村山航 (2011) 欠損データ分析(missing data analysis) ―完全情報最尤推定法と多重代入法―がわかりやすいと思う。英語だとcranのMissing DataのTask Viewやfinalfitというパッケージのvignetteがコンパクトでわかりやすい。

MARなのかMCARなのかを調べるLittleのMCAR検定については,mvnmleパッケージやBaylorEdPsychパッケージに含まれていたLittleMCAR()という関数があったが,どちらのパッケージも既にメンテナンスされなくなって久しく,cranから削除されている(Githubのcranアーカイヴに入っているので,devtoolsパッケージのinstall_github()関数を使ってcran/mvnmleのような指定をすればインストールできるが,メンテされていないパッケージを使うより,Little RJA (1988) A test of missing completely at random for multivariate data with missing values. Journal of the American Statistical Association, 83: 1198-1202.を読んで自分でコーディングした方が良い)。Task Viewに書かれている通り,RBtestパッケージでもMCAR性の検定ができるが,典拠となる文献が書かれていないし,回帰に基づく方法ということでLittleの方法とは違い,信頼できるかまだわからない。

データの大局的性質を把握するには,図示をするのが便利である。人間の視覚的認識能力は,パターン認識に関してはコンピュータより遥かに優れていると言われているから,それを生かさない手はない。また,入力ミスをチェックする上でも有効である。つまり,データ入力が終わったら,

何よりも先に図示をすべき

といえる。変数が表す尺度の種類によって,さまざまな図示の方法がある。離散変数の場合は,度数分布図,積み上げ棒グラフ,帯グラフ,円グラフが代表的であり,連続変数の場合はヒストグラム,正規確率プロット,箱ひげ図,散布図が代表的である。

以下,MASSパッケージに含まれているsurveyというデータフレームを使って作図する例を示す。

実際の作図に入る前に、色について簡単にまとめておく。修論などを見ていると、時々、カラー印刷される前提で、多数の色を使った図を見かけることがある。しかし、印刷物においてはモノクロになっても判別できるようにしておくことが重要である。投稿論文ではカラー図版には追加料金を請求されることが多いし、大学等のレギュレーションによって、正式に保存される論文はモノクロコピーであることが珍しくないからである。

したがって、印刷物(学会の抄録なども含めて)では、グラフの線は色分けではなく、実線、破線、一点鎖線のような線種で見分けがつくようにすることが望ましい。線だけでなく、データ点に打つシンボルの種類を変えることも有効な場合がある。領域も色による塗り分けではなく、角度や密度を変えたハッチングや粗さを変えた点描によって塗り分けるべきである。Rのコードでは、lty=というオプションで線種、lwd=で線の太さを指定できるようになっている関数が多い。図の中に凡例を明示することも必要である。

一方、学会発表や修論報告会などのプレゼンテーションにおいては、色分けが有効である。多くの関数で、col=というオプションにベクトル(整数または文字列。文字列は"black"のような色名でも有効だし、"#ffffff"のようにRGBに16進数2桁ずつを割り当てた文字列でも良い。"#ffffff77"のように最後の2桁で透過性を示すアルファチャンネルを指定することもできる)を与えることで色指定ができる。ただし、整数と色の対応関係のデフォルトの、1:黒、2:赤、3:緑、4:青、……という配色は、色覚多様性を考慮すると、必ずしも見分けやすくない。カラーユニバーサルデザインで推奨される配色セットを有効にするためには、palette("Okabe-Ito")を一度実行すれば良い。配色パレットが変わるので、それ以後ほとんどのグラフで使われる色が変わってくれる。グラフによっては領域塗りつぶしを重ねる必要がある場合があるが、その際はハッチングかアルファチャンネル指定を使うと良い。起動時に自動的にロードされるgrDevices関数に含まれているadjustcolor()関数を使えば、色名文字列と透過性を簡単に組み合わせることができる。

palette("Okabe-Ito") # カラーユニバーサルデザインの配色に

palette(adjustcolor(palette(), alpha.f=0.3)) # 配色そのままで透過度70%に

palette("R3") # R-3.*までのデフォルトパレットに

palette("default") # R-4.*のデフォルトパレットに

10人の身長・体重のデータでは作図の例示には向かないため,MASSパッケージに含まれているsurveyというデータフレームを使って説明する。MASSパッケージは推奨パッケージとしてWindows版のインストーラには元々含まれているし,RcmdrやEZRも依存しているので,別途インストールする必要はない。Rコンソールではlibrary(MASS)とするだけでがMASSパッケージがメモリにロードされ,surveyデータフレームが使える状態になる。

Rコマンダーでは,メニューの[ツール]の[パッケージのロード]を選んで表示されるウィンドウの中で,MASSを選ぶ。次に[データ]の[パッケージ内のデータ]の[アタッチされたパッケージからデータセットを読み込む]を選び,表示されるウィンドウの左の枠でMASSをダブルクリックし,次に右の枠でsurveyをダブルクリックし,[OK]ボタンをクリックする。

EZRでも,まずメニューの[ツール]の[パッケージのロード]を選んで表示されるウィンドウの中で,MASSを選ぶ51。「ファイル」メニューの「パッケージに含まれるデータを読み込む」から,パッケージとしてMASSをダブルクリックし,データセットとしてsurveyをダブルクリックしてから「OK」ボタンをクリックするだけでよい。

surveyというデータは,アデレード大学の学生237人の調査結果であり,含まれている変数は以下の通りである。

surveyの変数

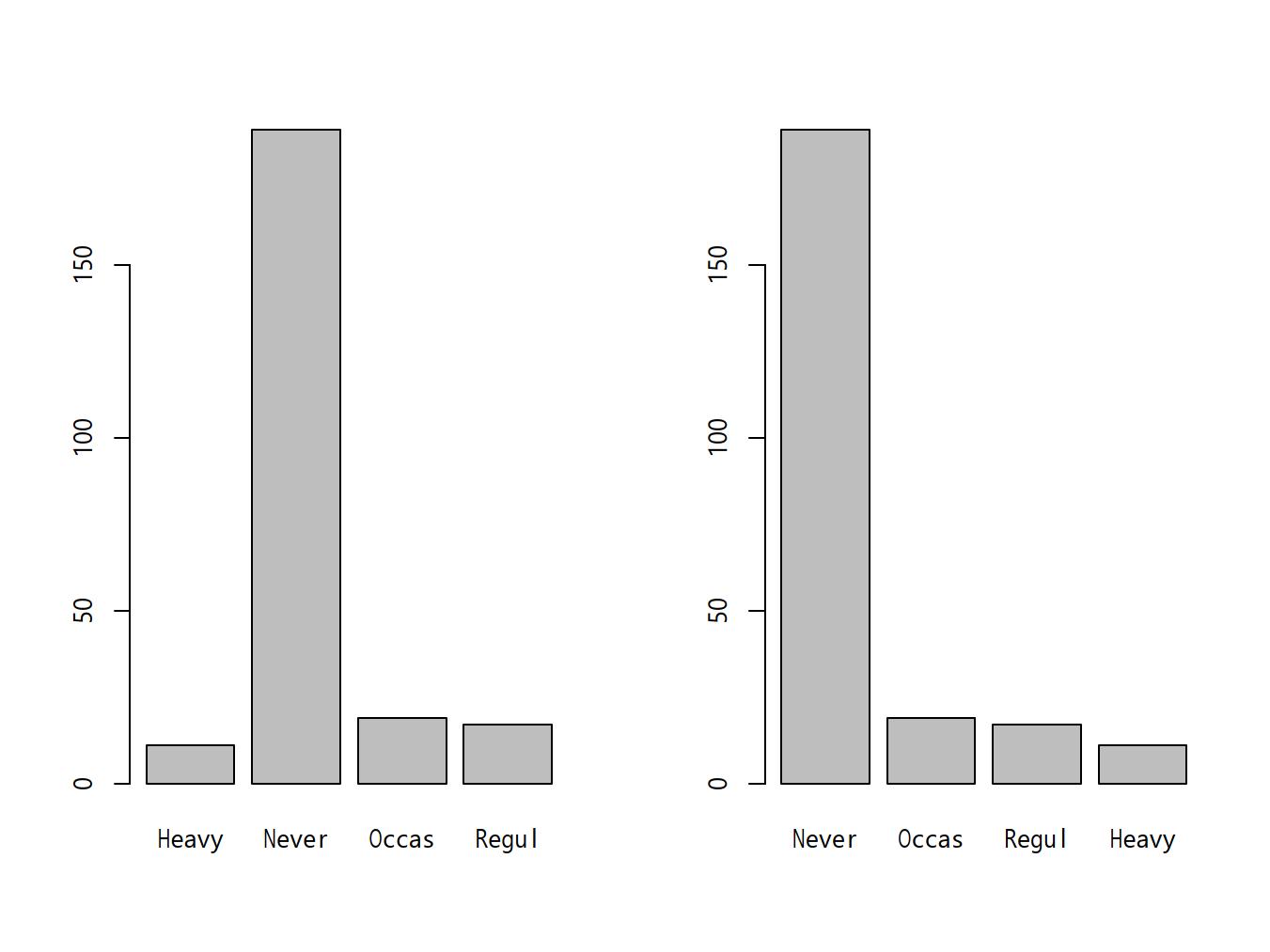

barplot(table(X))で描画される。上記surveyデータでSmokeのカテゴリごとの度数分布図を描くには,

barplot(table(survey$Smoke))barplot(table(survey$Smoke)[c("Never", "Occas", "Regul", "Heavy")])survey$Smoke <- factor(survey$Smoke, levels=c("Never", "Occas", "Regul", "Heavy"))

barplot(table(survey$Smoke)) Rcmdrでは上記

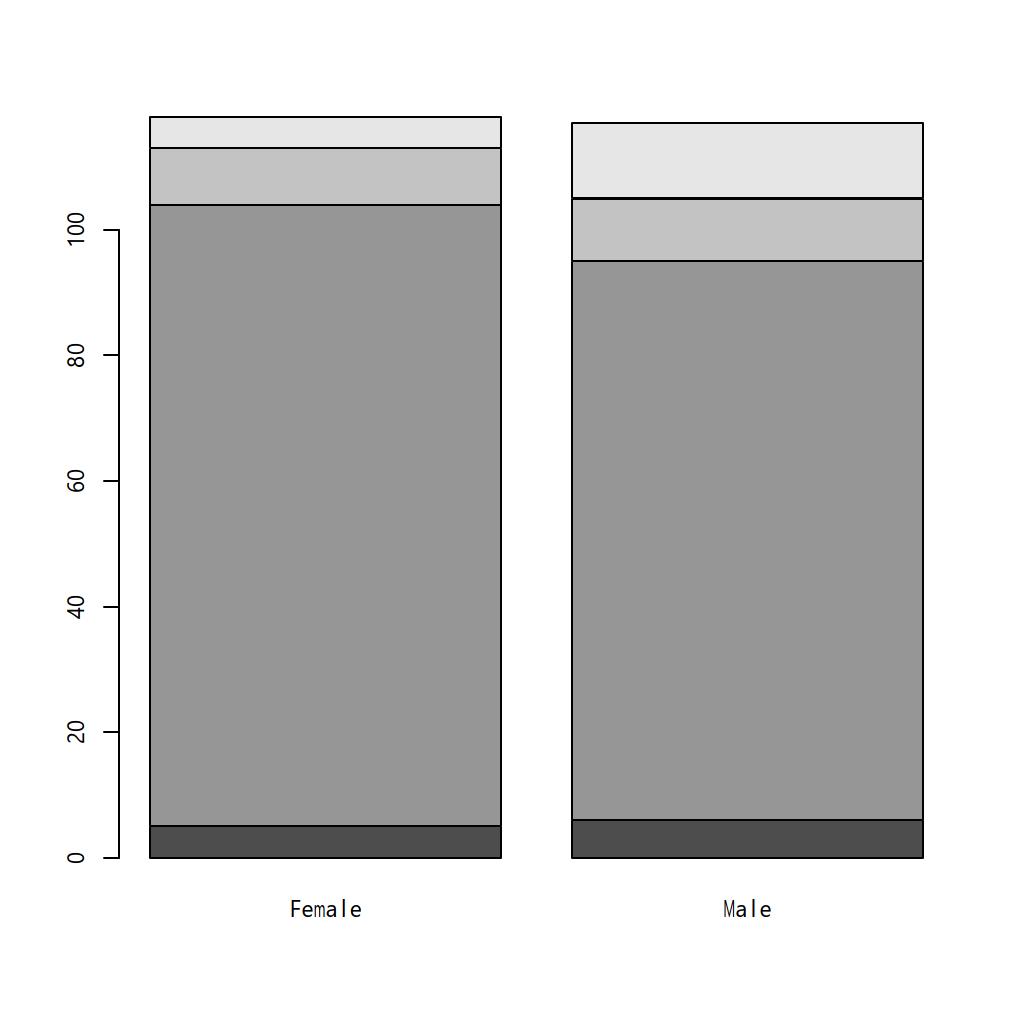

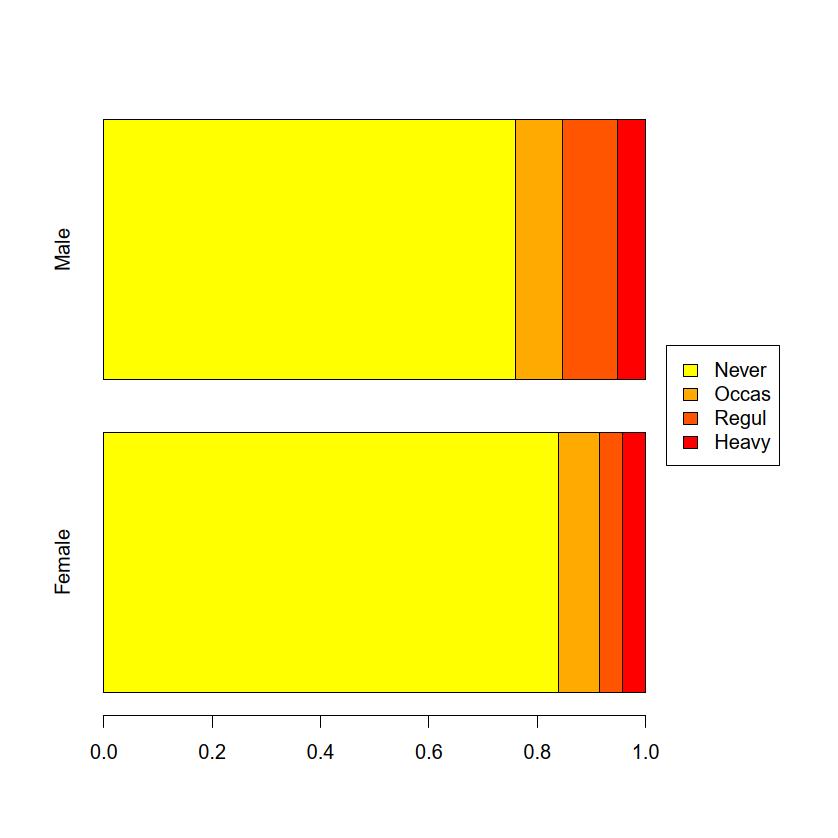

Rcmdrでは上記surveyデータフレームをアクティブにした状態で,「グラフ」の「棒グラフ」を選び(EZRでは「グラフと表」「棒グラフ(頻度)」を選ぶ),「変数(1つ選択)」の中からSmokeを選んで「OK」をクリックすると,喫煙習慣ごとの人数がプロットされる。Smokeを選び,因子の名前は<元と同じ>となっているので変えず,「順序のある因子の作成」の右側のボックスにチェックを入れてから「OK」ボタンをクリックする。「変数Smokeが既に存在します。上書きしますか?」というダイアログが表示されるのでOKし(もし元のカテゴリ順序の情報がなくなるのが嫌なら,因子の名前のところに既存の変数名と重複しない新しい名前を入力しておけば,このダイアログは出ない。その場合は新しい変数が作られる),「新しい順序」に表示したい順番を入力して「OK」ボタンをクリックする。この操作をしてから,「グラフと表」「棒グラフ(頻度)」でグラフを作ればよい。surveyデータフレームの喫煙習慣について積み上げ棒グラフを描くには,Rコンソールでは

barplot(as.matrix(table(survey$Smoke)))barplot(table(survey$Smoke, survey$Sex))barplot(xtabs(~Smoke+Sex, data=survey))

surveyデータフレームをアクティブにした状態で,「グラフと表」「棒グラフ(頻度)」を選び,「変数(1つ選択)」のところでSmokeを選ぶまでは度数分布を描くときと同じだが,「群別化変数1(0~1つ選択)」の中からもSexを選んで「OK」ボタンをクリックすることにより,層別積み上げ棒グラフを描くことができる。barplot(prop.table(table(survey$Smoke, survey$Sex), 2), horiz=TRUE)par(oma=c(0,0,0,6), xpd=NA)

Extent <- c("Never","Occas","Regul","Heavy")

FC <- rev(heat.colors(5)[1:4])

barplot(prop.table(table(survey$Smoke, survey$Sex)[Extent, ], 2),

horiz=TRUE, col=FC)

par(oma=c(0,0,0,0))

legend("right", fill=FC, legend=Extent)

surveyデータフレームをアクティブにした状態で,「グラフと表」「棒グラフ(頻度)」を選び,「変数(1つ選択)」のところでSmokeを選び,「群別化変数1(0~1つ選択)」の中からもSexを選ぶところまで層別積み上げ棒グラフと同じで,さらに「群間の比較の場合に各群の中の割合で描画する」の左側のチェックボックスにチェックを入れてから「OK」ボタンをクリックすると,全体が100%になる。windowsFonts(JP1=windowsFont("MS Gothic"))

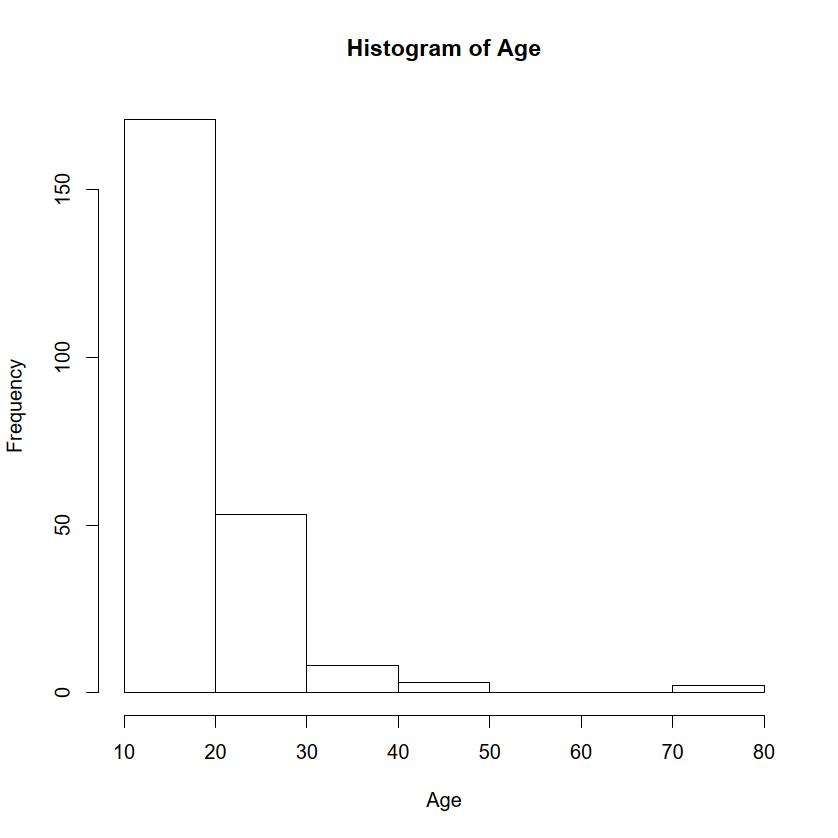

par(family="JP1")windowFont()の中はJP2, JP3などコンマで区切って複数のフォントを指定可能),選択してから「実行」ボタンをクリックし,出現するグラフィックウィンドウをそのままにして描画すれば,そこに描かれたグラフ要素はフォントがMSゴシックになるので,クリップボード経由でメタファイルとしてコピーペーストしても日本語が文字化けしなくなる。pie()関数を用いる。ただし錯覚しやすいのでお勧めしない。度数分布図の方が良い。surveyデータフレームをアクティブにした状態で,変数としてSmokeを選ぶと,喫煙習慣ごとの人数の割合に応じて円が分割された扇形に塗り分けられたグラフができる。hist()関数を用いる。デフォルトでは「適当な」区切り方として“Sturges”というアルゴリズムが使われるが,breaks=オプションにより明示的に区切りを与えることもできる。また,デフォルトでは区間が「~を超えて~以下」であり,日本で普通に用いられる「~以上~未満」ではないことにも注意されたい。「~以上~未満」にしたいときは,right=FALSEというオプションを付ければ良い。Rコンソールでsurveyデータフレームに含まれている年齢(Age)のヒストグラムを描かせるには,hist(survey$Age)だが,「10歳以上20歳未満」から10歳ごとの区切りでヒストグラムを描くように指定するには,

hist(survey$Age, breaks=1:8*10, right=FALSE, xlab="Age",

main="Histogram of Age")

surveyデータでは,変数としてAgeを選べば,年齢のヒストグラムが描ける(アデレード大学の学生のデータのはずだが,70歳以上の人や16.75歳など,大学生らしくない年齢の人も含まれている)。RcmdrやEZRでは「~以上~未満」にはできない(裏技的には,予め「~以上~未満」のカテゴリデータに変換しておき,「棒グラフ(頻度)」で描画することはできるが,バーの間に隙間があるのはヒストグラムとしては正当でないのでお勧めしない)。qqnorm()関数を用いる(getS3method("qqnorm","default")とすると実際のコードの中身がわかる。中で使われているppoints()関数の定義を見るには,ppointsと打てばよい)。Pulse)について正規確率プロットを描くには,qqnorm(survey$Pulse)とする。以下のように打つと同じグラフになることを確認されたい。

rPulse <- sort(survey$Pulse)

n <- length(rPulse)

tNorm <- qnorm((1:n-ifelse(n<=10, 3/8, 1/2))/n)

plot(tNorm, rPulse, main="Normal QQ plot")surveyデータフレームでは,変数としてAgeを選ぶと,まったく正規分布でないので直線状でないし,Pulseを選ぶと,やや歪んでいるけれども概ね直線に乗るので正規分布に近いことがわかる。また,EZRでは,「統計解析」「連続変数の解析」「正規性の検定(Kolmogorov-Smirnov検定)」でも,正規性の検定が実施されるのと同時にヒストグラムに正規分布の曲線を重ね描きしてくれるので,正規分布と見なせるかどうかは見当がつく。stem()関数を用いる。同じデータで心拍数の幹葉表示をするには,stem(survey$Pulse)とする。

The decimal point is 1 digit(s) to the right of the |

3 | 5

4 | 0

4 | 88

5 | 004

5 | 569

6 | 000000000000122223444444444

6 | 555555666666788888888888888889

7 | 00000000000001122222222222222344444

7 | 5555566666666666668888999

8 | 0000000000000000001333344444

8 | 55556667788889

9 | 00000000222222

9 | 66678

10 | 0044fmsbパッケージのgstem()関数を使えばグラフィック画面に出力することもできる。Rcmdrには含まれていない。EZRでは「グラフと表」「幹葉表示」を選び,「変数(1つ選択)」の枠内からPulseを選んで「OK」ボタンをクリックすればOutputウィンドウにテキスト出力される。さまざまなオプションが指定可能である。boxplot()関数を用いる。例えば,surveyデータで喫煙状況(Smoke)別に心拍数(Pulse)の箱ヒゲ図を描くには次の2行のどちらかを打つ。

boxplot(survey$Pulse ~ survey$Smoke)

boxplot(Pulse ~ Smoke, data=survey)

Pulseを選び,[層別のプロット]というボタンをクリックして表示されるウィンドウで,層別変数としてSmokeを選んで[OK]ボタンをクリックしてから,戻ったウィンドウで再び[OK]をクリックすればいい(EZRの場合は「群別する変数(0~1つ選択)でSmokeを選び,上下のひげの位置として「第1四分位数-1.5x四分位範囲、第3四分位数+1.5x四分位範囲」の左のラジオボタンをチェックして「OK」をクリックするだけでよい)。Smoke,「目的変数」としてPulseを選べばよい。エラーバーとしては標準誤差(デフォルト),標準偏差,信頼区間から選択できる。plotrixパッケージかfmsbパッケージをインストールする必要がある。どちらもCRANのミラーサイトからダウンロードしてインストールできる。インターネットにつながったいる環境ならば,前者はinstall.packages("plotrix"),後者はinstall.packages("fmsb")とすればインストールできる。その上で,例えば後者の場合なら,library(fmsb)としてからexample(radarchart)とすれば使い方がわかる52。

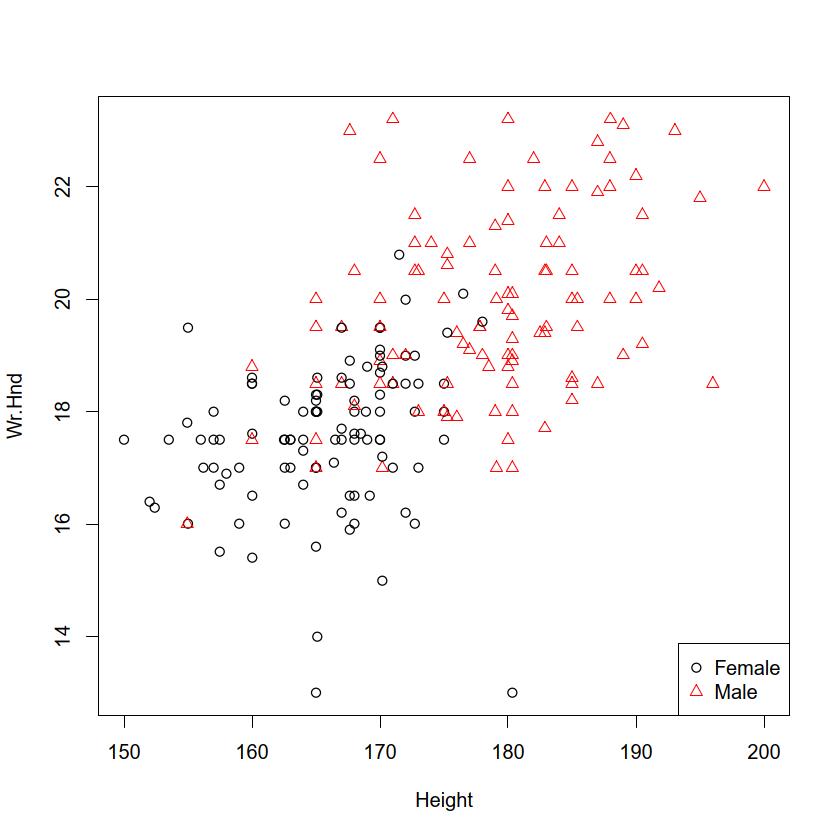

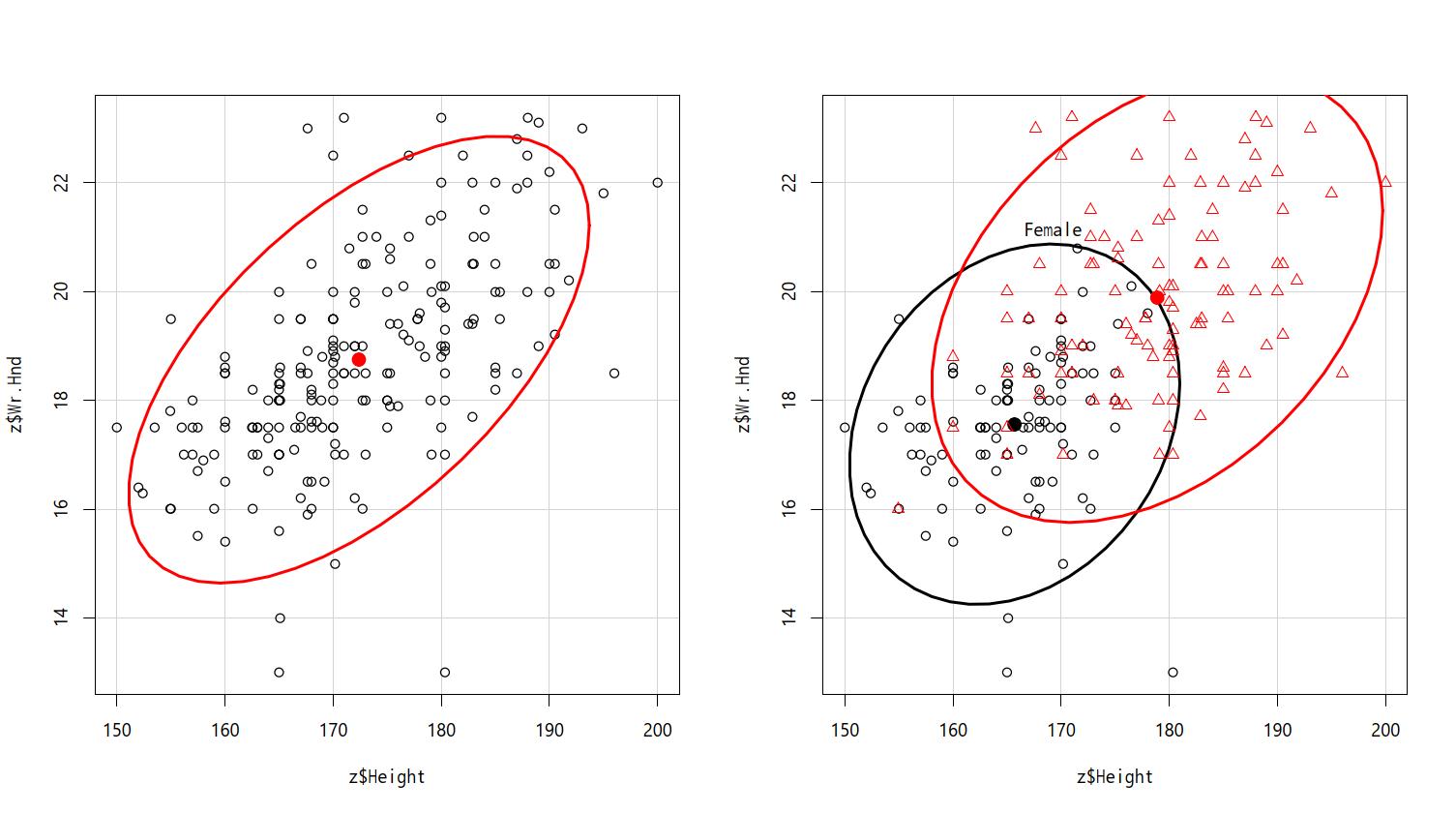

RcmdrやEZRのメニューには入っていない。plot()関数を用いる(ただし,実はRのplot()関数は総称的関数なので,縦軸が数値変数で,横軸がカテゴリ変数であるときは自動的に層別箱ひげ図になる)。データ点に文字列を付記したい場合はtext()関数が使えるし,マウスで選んだデータ点にだけ文字列を付記したい場合はidentify()関数が使える。MASSパッケージのsurveyデータフレームに含まれるHeightを横軸に,Wr.Hndを縦軸にして散布図を描きたい場合は以下2行のどちらかを打つ。

plot(Wr.Hnd ~ Height, data=survey)

plot(survey$Height, survey$Wr.Hnd)plot(Wr.Hnd ~ Height, data=survey, pch=as.integer(Sex),

col=as.integer(Sex))legend("bottomright", pch=1:2, col=1:2, legend=c("Female", "Male"))とすればよい。points()関数を使って重ね打ちすることもできる。点ごとに異なる情報を示したい場合(異なる大きさの円でプロットするなど)はsymbols()関数を用いることができる。

Rcmdrでは「グラフ」「散布図」,EZRでは「グラフと表」「散布図」を選び,「x変数(1つ選択)」からHeightを,「y変数(1つ選択)」からWr.Hndを選んで,「周辺箱ひげ図」と「最小2乗直線」(Rcmdrでは「平滑線」)の左のボックスのチェックを外してから「OK」をクリックすれば,上と同じような図が描ける。オプション指定で層別にマークを変えることもできる。[層別のプロット]ボタンをクリックして層別変数としてSexを選べばよい。できあがった散布図の点をマウスでクリックして値を確認したい時は,x変数やy変数を指定するウィンドウで,「点を確認する」にチェックを入れておく。確認したい点の上で左クリックするとレコード番号が表示され,右クリックするまで繰り返すことができる。

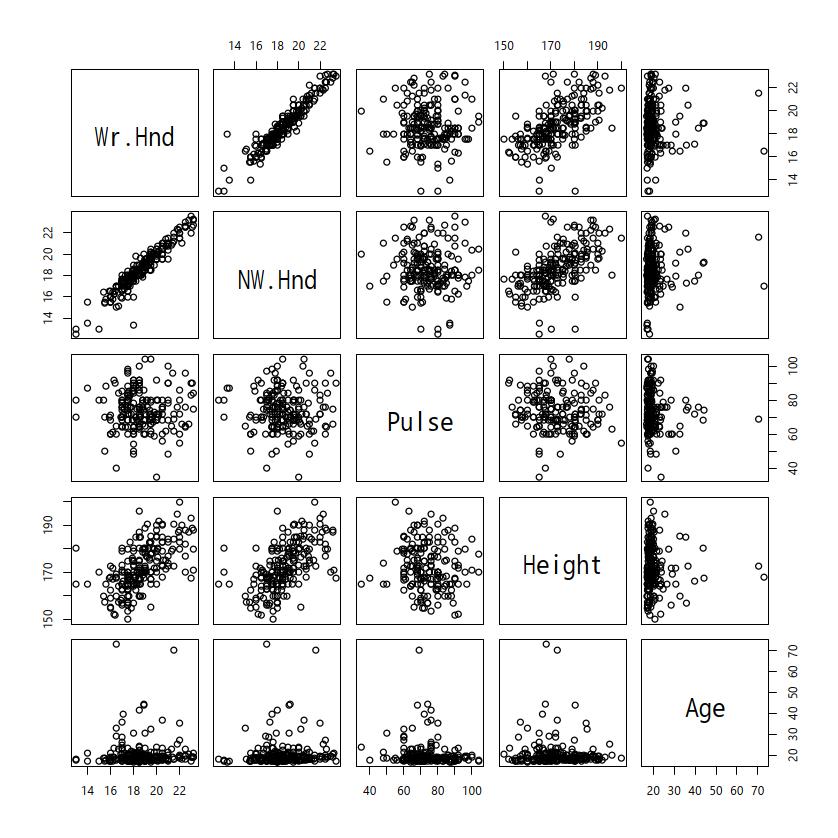

複数の連続変数間の関係を調べたい場合は,matplot()関数とmatpoints()関数を使って重ね描きすることもできるが,別々のグラフとして並べて同時に示す「散布図行列」を描画するのが便利である。pairs()関数を用いる。例えば,MASSパッケージのsurveyデータフレームに含まれるすべての数値型変数(Wr.Hnd,NW.Hnd,Pulse,Height,Age)について散布図行列を作りたいときは,

pairs(subset(survey, select=sapply(survey, is.numeric)))Wr.Hnd,Pulse,Ageの3つの関係だけを調べたいなら,

pairs(~ Wr.Hnd+Pulse+Age, data=survey)

pairs()の機能が実装されている。オプション指定により,対角線上に個々の変数についてのさまざまなグラフを表示できるのが便利である。記述統計は,(1)データの特徴を把握する目的,また(2)データ入力ミスの可能性をチェックする目的で計算する。あまりにも妙な最大値や最小値,大きすぎる標準偏差などが得られた場合は,入力ミスを疑って,元データに立ち返ってみるべきである。

記述統計量には,大雑把にいって,分布の位置を示す「中心傾向」と分布の広がりを示す「ばらつき」があり,中心傾向としては平均値,中央値,最頻値がよく用いられ,ばらつきとしては分散,標準偏差,四分位範囲,四分位偏差がよく用いられる。

中心傾向の代表的なものは以下の3つである。

分布の位置を示す指標として,もっとも頻繁に用いられる。実験的仮説検証のためにデザインされた式の中でも,頻繁に用いられる。記述的な指標の1つとして,平均値は,いくつかの利点と欠点をもっている。日常生活の中でも平均をとるという操作は普通に行われるから説明不要かもしれないが,数式で書くと以下の通りである。

母集団の平均値μ(ミューと発音する)は,μ = ∑X / Nである。Xはその分布における個々の値であり,Nは値の総数である。∑(シグマと発音する)は,一群の値の和を求める記号である。すなわち,∑X = X1 + X2 + X3 + ... + XNである。

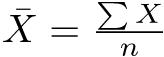

標本についての平均値を求める式も,母集団についての式と同一である。ただし,数式で使う記号が若干異なっている。標本平均X(エックスバーと発音する)は, である。nは,もちろん標本サイズである53。

である。nは,もちろん標本サイズである53。

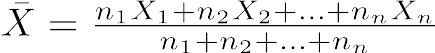

ちなみに,重み付き平均は,各々の値にある重みをかけて合計したものを,重みの合計で割った値である。重みをn1,n2,……として,各々の値をX1,X2,……として式で書くと,

中央値は,全体の半分がその値より小さく,半分がその値より大きい,という意味で,分布の中央である。言い換えると,中央値は,頻度あるいは値の数に基づいて分布を2つに等分割する値である。中央値を求めるには式は使わない(決まった手続き=アルゴリズムとして,並べ替え(sorting)は必要)。極端な外れ値の影響を受けにくい(言い換えると,外れ値に対して頑健である)。歪んだ分布に対する最も重要なcentral tendencyの指標が中央値である。Rで中央値を計算するには,median()という関数を使う。なお,データが偶数個の場合は,普通は中央にもっとも近い2つの値を平均した値を中央値として使うことになっている。

最頻値はもっとも度数が多い値である。すべての値の出現頻度が等しい場合は,最頻値は存在しない。Rではtable(X)[which.max(table(X))]で得られる(ただし,複数の最頻値がある場合は,これだと最も小さい値しか表示されないので要注意)。

平均値は,(1)分布のすべての値を考慮した値である,(2)同じ母集団からサンプリングを繰り返した場合に一定の値となる,(3)多くの統計量や検定で使われている,という特長をもつ。標本調査値から母集団の因果関係を推論したい場合に,もっとも普通に使われる。しかし,(1)極端な外れ値の影響を受けやすい,(2)打ち切りのある分布では代表性を失う場合がある54,という欠点があり,外れ値があったり打ち切りがあったりする分布では位置の指標として中央値の方が優れている。最頻値は,標本をとったときの偶然性の影響を受けやすいし,もっとも頻度が高い値以外の情報はまったく使われない。しかし,試験の点で何点の人が多かったかを見たい場合は最頻値が役に立つし,名義尺度については最頻値しか使えない。

ここで上げた3つの他に,幾何平均(geometric mean)や調和平均(harmonic mean)も,分布の位置の指標として使われることがある。幾何平均はデータの積の累乗根(対数をとって平均値を出して元に戻したもの),調和平均はデータの逆数の平均値の逆数であり,どちらもゼロを含むデータには使えない。大きな外れ値の影響を受けにくいという利点があり,幾何平均は,とくにデータの分布が対数正規分布に近い場合によく用いられる。

一方,分布のばらつき(Variability)の指標として代表的なものは,以下の4つである。

四分位範囲について説明する前に,分位数について説明する。値を小さい方から順番に並べ替えて,4つの等しい数の群に分けたときの1/4, 2/4, 3/4にあたる値を,四分位数(quartile)という。1/4の点が第1四分位,3/4の点が第3四分位である(つまり全体の25%の値が第1四分位より小さく,全体の75%の値が第3四分位より小さい)。2/4の点というのは,ちょうど順番が真中ということだから,第2四分位は中央値に等しい。ちょっと考えればわかるように,ちょうど4等分などできない場合がもちろんあって,上から数えた場合と下から数えた場合で四分位数がずれる可能性があるが,その場合はそれらを平均するのが普通である。また,最小値,最大値に,第1四分位,第3四分位と中央値を加えた5つの値を五数要約値と呼ぶことがある(Rではfivenum()関数で五数要約値を求めることができる)。第1四分位,第2四分位,第3四分位は,それぞれQ1, Q2, Q3と略記することがある。四分位範囲とは,第3四分位と第1四分位の間隔である。上と下の極端な値を排除して,全体の中央付近の50%(つまり代表性が高いと考えられる半数)が含まれる範囲を示すことができる。

四分位範囲を2で割った値を四分位偏差と呼ぶ。もし分布が左右対称型の正規分布であれば,中央値マイナス四分位偏差から中央値プラス四分位偏差までの幅に全データの半分が含まれるという意味で,四分位偏差は重要な指標である。IQRもSIQRも少数の極端な外れ値の影響を受けにくいし,分布が歪んでいても使える指標である。

データの個々の値と平均値との差を偏差というが,マイナス側の偏差とプラス側の偏差を同等に扱うために,偏差を二乗して,その平均をとると,分散という値になる。分散Vは,

V = Σ(X - μ)2 / N

で定義される55。標本分散V(X)は,標本平均Xを使って,

V(X) = Σ (X - X)2 / n

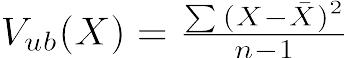

という式で得られる。ただし,標本平均がそのまま母平均の推定値となるのに対して,標本分散は母分散の推定値にならない。母分散の推定値としては,標本サイズnで割る代わりに自由度n − 1で割って得られる不偏分散(unbiased variance)という値を用いる。即ち,不偏分散Vub(X)は,

である(Rでは

である(Rではvar()で得られる)。

分散の平方根をとったものが標準偏差である。平均値と次元を揃える意味をもつ。不偏分散の平方根をとったものは,不偏標準偏差と呼ばれる(Rではsd()で得られる)56。もし分布が正規分布ならば,Mean±2SD57の範囲にデータの95%が含まれるという意味で,標準偏差は便利な指標である。なお,名前は似ているが,「標準誤差」はデータのばらつきでなくて,推定値のばらつきを示す値なので混同しないように注意されたい。例えば,平均値の標準誤差は,標本の不偏標準偏差を標本サイズの平方根で割れば得られるが,意味は,「もし標本抽出を何度も繰り返して行ったとしたら,得られる標本平均のばらつきは,一定の確率で標準誤差の範囲におさまる」ということである。ちなみに,データそのものがどのような分布であっても,標本抽出回数を増やしていくと,標本平均の分布は正規分布に近づくことが中心極限定理によって証明されている。例えば,区間(0, 1)の一様分布から,サイズ10の無作為標本を1000回抽出すると,その平均値の分布がほぼ正規分布していることは,以下のコードで確かめることができる。

x <- runif(10000)

y <- matrix(numeric(1000*10), 10)

for (i in 1:1000) { y[, i] <- sample(x, 10, replace=FALSE) }

hist(colMeans(y))上記の記述統計量を計算するには,Rcmdrからは,メニューバーの「統計量」の「要約」から「数値による要約」を選べばよいし,EZRでは,「統計解析」の「連続変数の解析」の「連続変数の要約」を選べばよい。選びたい変数の上にマウスカーソルを移動し,を押しながら左クリックすることで,複数の変数を選択することができる。オプションをとくに指定しなければ,平均値,標準偏差,最小値,第1四分位(25パーセンタイル),中央値(50パーセンタイル),第3四分位(75パーセンタイル),最大値,有効標本サイズ,欠損値の数が,選択した変数すべてについて表示される。

分布の正規性の検定は,コルモゴロフ=スミルノフ検定あるいはシャピロ=ウィルク検定が有名である。fmsbパッケージにはギアリーの検定も実装してある。もちろん検定をする前に,ヒストグラムか正規確率プロットによって分布の様子を確認しておくことは必須である。例えば,surveyデータフレームに含まれているNW.Hndという変数(利き手でない方の手を開いたときの親指と小指の先の距離)について分布の正規性の検定を行うには以下のように打つ。

mu <- mean(survey$NW.Hnd[!is.na(survey$NW.Hnd)])

psd <- sd(survey$NW.Hnd[!is.na(survey$NW.Hnd)])

ks.test(survey$NW.Hnd, "pnorm", mean=mu, sd=psd)

shapiro.test(survey$NW.Hnd)EZRでは,「統計解析」の「連続変数の解析」の「正規性の検定」を選び,変数としてNW.Hndを選んでOKボタンをクリックするだけでできる。自動的にコルモゴロフ=スミルノフ検定の(サンプルサイズが5000以下のときはシャピロ=ウィルク検定も)結果が表示され,ヒストグラムに正規分布を重ね描きしたグラフも作成される。コルモゴロフ=スミルノフ検定とシャピロ=ウィルク検定の結果が異なることがあるが,これらの検定は分布の正規性へのアプローチが異なるので,結果が一致しないこともある。また,多くの検定手法がデータの分布の正規性を仮定しているが,これらの検定で正規性が棄却されたからといって機械的に変数変換やノンパラメトリック検定でなくてはいけないとは限らない。独立2標本の平均値の差がないという仮説を検定するためのt検定(等分散性を仮定しないWelchの方法も含めて)は頑健な手法なので,正規分布に従っているといえなくても,そのまま実行してもいい場合も多い。ただし,明らかな外れ値がある場合は検出力が落ちるので,Wilcoxonの順位和検定のようなノンパラメトリックな検定の方が良い場合もある。

外れ値についても,グラフで確認することは必須である。統計学的に有意に正規分布から外れているかどうかの検定にも何種類かあるが,スミルノフ=グラブス検定は,outliersパッケージに含まれているgrubbs.test()関数や群馬大学の青木繁伸教授がwebサイトで提供しているSG()関数58によって実行可能である。

EZRでは,「統計解析」の「連続変数の解析」の「外れ値の検定」を選んで,変数としてNW.Hndを指定してOKボタンをクリックするだけでいい。外れ値をNAで置き換えた新しい変数を作成することも右のオプション指定から容易にできる。有意な外れ値がない場合は,“No outliers were identified.”と表示されるが,既に書いた通り,この結果だけで機械的に外れ値を除外することはお薦めできない。

ばらつきとは別に、データの分布の形を示す記述統計量として、尖度(kurtosis)と歪度(skewness)が使われる。これらはR本体には関数として実装されていないが、e1071パッケージに入っている。そのhelpによると、Joanes and Gill (1988)に基づいて、それぞれ3通りの計算方法が実装されており、オプションとして指定できる。

古典的定義(歪度を3次のモーメントを2次のモーメントの平方根の3乗で割った値、尖度を4次のモーメントを2次のモーメントの二乗で割って3を引いた値とする定義。ちなみにr次のモーメントとは平均からの偏差のr乗和をサンプルサイズで割った値である)に基づくのがtype=1で、SASやSPSSと同じ実装がtype=2(e1071パッケージのヘルプでは表示されないが、Joanes and Gill, 1988によると、EXCELもこの実装を採用しているとのこと)、MINITABやBMDPと同じ実装がtype=3で、どちらもデフォルトはtype=3とのこと。

正規分布の下で不偏推定量であることがわかっているのは、歪度の方は3つともだが、尖度はtype=2だけとのことなので(なぜtype=2をデフォルトにしなかったのか謎だが)、R本体でlibrary(e1071)からskewness()やkurtosis()を使う場合は、特別な理由がない限り、type=2を指定すべきであろう。

EZRでは統計解析>連続変数の解析>正規性の検定でアウトプットウィンドウの中に表示されるが、type=2の結果と同じようだ。

jamoviは探索(Exploration)の記述統計(Descriptives)で変数を選んで計算させた後で統計量(Statistics)の分布(Distribution)の下にある歪度(skewness)と尖度(kurtosis)にチェックを入れるとtype=2と同じ結果が表示される。

医学統計ではSASやSPSSと同じ結果になるのが無難な選択であろうから、EZRの方針は合理的だと思う。元々心理統計のために開発されたらしいjamoviも、最近は医学論文でも使われているから、妥当な選択であろう。

なお、EZRやjamoviでは欠損値があっても自動的に除去して計算してくれるが、e1071パッケージのskewness()やkurtosis()は標準関数のmean()やvar()と同じく、na.rm=FALSEオプションがデフォルトなので、欠損値が含まれていると結果がNAになる。欠損値を除去して計算させたい場合は、na.rm=TRUEというオプション指定も必要である。

論文を書く場合,結果の最初にTable 1としてサンプルの基本属性の集計結果をまとめて表示することが多い。EZRは,バージョンアップによって,この機能を内蔵するようになった。メニューの「グラフと表」の「サンプルの背景データのサマリー表の出力」を選び,群別する変数(0~1つ選択),カテゴリー変数(名義変数、順序変数),連続変数(正規分布),連測変数(非正規分布)59を選び,正規分布しない連続変数の範囲表示をデフォルトの「最小値と最大値」にするのか「四分位範囲(Q1-Q3)」にするのかを選んでから「OK」をクリックする。

cranにはtable1というパッケージが存在し,名前の通り,Table 1を見やすく作るための機能を提供している。詳細はhttps://cran.r-project.org/web/packages/table1/vignettes/table1-examples.htmlに説明されている。同じ目的でtableoneというパッケージも存在し,https://cran.r-project.org/web/packages/tableone/vignettes/introduction.htmlに使い方が説明されている。他にもたくさんのパッケージが似た目的で開発されており,比較記事60が書かれていて参考になる。

医学統計でよく使われるのは,伝統的に仮説検定である。仮説検定は,意味合いからすれば,元のデータに含まれる情報量を,仮説が棄却されるかどうかという2値情報にまで集約してしまうことになる。これは情報量を減らしすぎであって,点推定量と信頼区間を示す方がずっと合理的なのだが,伝統的な好みの問題なので,この演習でも検定を中心に説明する。もっとも,RothmanとかGreenlandといった最先端の疫学者は,仮説検定よりも区間推定,区間推定よりもp値関数の図示(リスク比やオッズ比については,fmsbパッケージにpvalueplot()関数として実装済み)の方が遥かによい統計解析であると断言している。

最も単純な検定の1つは,独立2標本間の分布の位置の差の検定であり,非常によく使われているので,まずはここから検定の考え方を見てみよう。

典型的な例として,独立にサンプリングされた2群の平均値の差がないという帰無仮説の検定を考えよう。通常,研究者は,予め,検定の有意水準を決めておかねばならない。検定の有意水準とは,間違って帰無仮説が棄却されてしまう確率が,その値より大きくないよう定められるものである。ここで2つの考え方がある。フィッシャー流の考え方では,p値(有意確率)は,観察されたデータあるいはもっと極端なデータについて帰無仮説が成り立つ条件付き確率である。もし得られたp値が小さかったら,帰無仮説が誤っているか,普通でないことが起こったと解釈される。ネイマン=ピアソン流の考え方では,帰無仮説と対立仮説の両方を定義しなくてはならず,研究者は繰り返しサンプリングを行ったときに得られる,この手続きの性質を調べる。即ち,本当は帰無仮説が正しくて棄却されるべきではないのに誤って棄却するという決断をしてしまう確率(これは「偽陽性」あるいは第一種の過誤と呼ばれる)と,本当は誤っている帰無仮説を誤って採択してしまう確率(第二種の過誤と呼ばれる)の両方を調べる。これら2つの考え方は混同してはならず,厳密に区別すべきである。

通常,有意水準は0.05とか0.01にする。上述の通り,検定の前に決めておくべきである。得られた有意確率がこの値より小さいとき,統計的な有意性があると考えて帰無仮説を棄却する。

独立2群間の統計的仮説検定の方法は,以下のようにまとめられる。

shapiro.test()でShapiro-Wilkの検定ができるが,その結果を機械的に適用して判断すべきではない):Welchの検定(Rではt.test(x,y))61wilcox.test(x,y))が標準的に使われてきたが(Mann-WhitneyのU検定という言い方もあるが,数学的にまったく同じ検定である),これらは分布の形は仮定しないけれども,2群が連続分布であることと,分布の形に差がない「ズレのモデル」を前提としているため,それさえも仮定しない,Brunner-Munzel検定が最近提案され,広まりつつある。prop.test())。次章で扱う。標本調査によって得られた独立した2つの量的変数XとY(サンプルサイズが各々nXとnYとする)の比較を考える。

2つの量的変数XとYの不偏分散SX<-var(X)とSY<-var(Y)の大きい方を小さい方で(以下の説明ではSX>SYだったとする)割ったF0<-SX/SYが第1自由度DFX<-length(X)-1,第2自由度DFY<-length(Y)-1のF分布に従うことを使って検定する。有意確率は1-pf(F0,DFX,DFY)で得られる。しかし,F0を手計算しなくても,var.test(X,Y)で等分散かどうかの検定が実行できる。また,1つの量的変数Xと1つの群分け変数Cがあって,Cの2群間でXの分散が等しいかどうか検定するというスタイルでデータを入力してある場合は,var.test(X~C)とすればよい。

この結果,2群間で分散が統計的に有意に異なっていたら,その情報自体が,異なる母集団からのサンプルであるとか,サンプリングが偏っていた可能性を示唆する。かつては,等分散性の検定結果によって平均値の差のt検定において等分散性を仮定したりWelchの方法にしたりといったことをしていたが,現在では,等分散と考えられるかどうかによらず,Welchの方法で検定すれば良い。

Rcmdrでは「統計量」の「分散」から「分散の比のF検定」を選び,グループ(Group variable)としてCを,目的変数(Response variable)としてXを選ぶ。ただし,グループ変数は要因型になっていないと候補として表示されないので,もし0/1で入力されていたら,予め「データ」の「アクティブデータセット内の変数の操作」で「数値変数を因子に変換」を用いて要因型にしておく(字面は0/1のままでもOK)。surveyデータで,「男女間で身長の分散に差がない」という帰無仮説を検定するには,グループとしてSexを,目的変数としてHeightを選んで[OK]ボタンをクリックする。デフォルトでは両側検定されるが,仮説によっては片側検定をすることもあり,その場合は「対立仮説」の下のラジオボタンのチェックを変えればいい。男女それぞれの分散と,検定結果が「出力ウィンドウ」に表示される。

EZRでは,「統計解析」の「連続変数の解析」から「2群の等分散性の検定(F検定)」を選び,目的変数(1つ選択)の枠からXを,グループ(1つ選択)の枠からCを選び(EZRでは要因型にしなくても選べる), OKボタンをクリックする。surveyデータで,「男女間で身長の分散に差がない」という帰無仮説を検定するには,目的変数としてHeightを,グループとしてSexを選び,OKボタンをクリックすると,男女それぞれの分散と検定結果がOutputウィンドウに表示される。

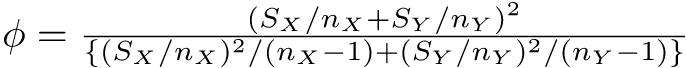

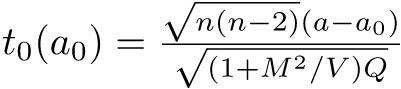

が自由度ϕのt分布に従うことを使って検定する。但し,ϕは下式による。

が自由度ϕのt分布に従うことを使って検定する。但し,ϕは下式による。

Rでは,t.test(X,Y,var.equal=F)だが,var.equalの指定を省略した時は等分散でないと仮定してWelchの検定がなされるので省略してt.test(X,Y)でいい。量的変数Xと群分け変数Cという入力の仕方の場合は,t.test(X~C)とする62。surveyデータで「男女間で平均身長に差がない」という帰無仮説を検定したいときは,t.test(Height ~ Sex, data=survey)とする。

なお,t検定の効果量については,第5章「研究のデザイン」で既に述べたので,そちらを参照されたい。

Rcmdrでは「統計量」の「平均値」の「独立サンプルt検定」を選んで,グループ(Group variable)としてCを,目的変数(Response variable)としてXを選んで,等分散と考えますか? というラジオボタンは「No」にしておき,両側検定か片側検定かを選んでから[OK]ボタンをクリックする。ただし,グループ変数は要因型になっていないと候補として表示されないので,もし0/1で入力されていたら,予め「データ」の「アクティブデータセット内の変数の管理」で「数値変数を因子に変換」を用いて要因型にしておく(字面は0/1のままでもOK。具体的には下の例題を参照)。surveyデータで「男女間で平均身長に差がない」という帰無仮説を検定したいときは,グループとしてSexを,目的変数としてHeightを選べばよい。Welchの方法による2標本t検定の結果が「出力ウィンドウ」に表示される。

EZRの場合は「統計解析」「連続変数の解析」から「2群間の平均値の比較(t検定)」を選び,目的変数としてHeightを,比較する群としてSexを選び,「等分散と考えますか?」の下のラジオボタンを「No (Welch test)」の方をチェックして,「OK」ボタンをクリックすると,結果がOutputウィンドウに表示される。男女それぞれの平均,不偏標準偏差と検定結果のp値が示され,エラーバーが上下に付いた平均値を黒丸でプロットし,それを直線で結んだグラフも自動的に描かれる。

ちなみに,surveyデータで年齢(Age)に性差があるかどうかを検定したい場合にWelchのt検定をすると,年齢は明らかに正規分布から大きく外れており,かつ外れ値が多いので検出力が落ちる。実際にやってみるとわかるが有意でない。

なお,既に平均値と不偏標準偏差が計算されている場合の図示は,エラーバー付きの棒グラフがよく使われるが(barplot()関数で棒グラフを描画してから,arrows()関数でエラーバーを付ければよい),棒グラフを描く時は基線をゼロにしなくてはいけないことに注意されたい。生データがあれば,stripchart()関数を用いて,生データのストリップチャートを描き,その脇に平均値とエラーバーを付け足す方がよい。そのためには,量的変数と群別変数という形にしなくてはいけないので,たとえば,2つの量的変数V <- rnorm(100,10,2)とW <- rnorm(60,12,3)があったら,予め

X <- c(V, W)

C <- as.factor(c(rep("V", length(V)), rep("W", length(W))))

x <- data.frame(X, C)または

x <- stack(list(V=V, W=W))

names(x) <- c("X", "C")のように変換しておく必要がある63。プロットするには次のように入力すればよい64。

stripchart(X~C, data=x, method="jitter", vert=TRUE)

Mx <- tapply(x$X, x$C, mean)

Sx <- tapply(x$X, x$C, sd)

Ix <- c(1.1, 2.1)

points(Ix, Mx, pch=18, cex=2)

arrows(Ix, Mx-Sx, Ix, Mx+Sx, angle=90, code=3)各対象について2つずつの値があるときは,それらを独立2標本とみなすよりも,対応のある2標本とみなす方が切れ味がよい。全体の平均に差があるかないかだけをみるのではなく,個人ごとの違いを見るほうが情報量が失われないのは当然である。

対応のある2標本の差の検定は,paired-t検定と呼ばれ,意味合いとしてはペア間の値の差を計算して値の差の母平均が0であるかどうかを調べることになる。Rで対応のある変数XとYのpaired-t検定をするには,t.test(X,Y,paired=T)で実行できるし,それはt.test(X-Y,mu=0)と等価である。

surveyデータで「親指と小指の間隔が利き手とそうでない手の間で差がない」という帰無仮説を検定するには,Rコンソールでは,

t.test(survey$Wr.Hnd, survey$NW.Hnd, paired=TRUE)と打てばよい。グラフは通常,同じ人のデータは線で結ぶので,例えば次のように打てば,差が1 cm以内の人は黒,利き手が1 cm以上非利き手より大きい人は赤,利き手が1 cm以上非利き手より小さい人は緑で,人数分の線分が描かれる。

Diff.Hnd <- survey$Wr.Hnd - survey$NW.Hnd

C.Hnd <- ifelse(abs(Diff.Hnd)<1, 1, ifelse(Diff.Hnd>0, 2, 3))

matplot(rbind(survey$Wr.Hnd, survey$NW.Hnd), type="l",

lty=1, col=C.Hnd, xaxt="n")

axis(1, 1:2, c("Wr.Hnd", "NW.Hnd"))

Rcmdrでは「統計量」の「平均」の「対応のあるt検定」を選ぶ(EZRでは「統計解析」「連続変数の解析」から「対応のある2群間の平均値の検定(paired t検定)」を選ぶ)。第1の変数としてWr.Hndを,第2の変数としてNW.Hndを選び,[OK]ボタンをクリックすると,出力ウィンドウ(EZRではOutputウィンドウ)に結果が得られる。有意水準5%で帰無仮説は棄却され,利き手の方がそうでない手よりも親指と小指の間隔が有意に広いといえる。

なお,対応のあるt検定の意味を考えれば,EZRでも「アクティブデータセット>変数の操作>計算式を入力して新たな変数を作成する」として,新しい変数名としてDiff.Hndとして,計算式としてWr.Hnd-NW.HndとしてOKをクリックすることで手の大きさの差の変数を作り,このDiff.Hndの母平均がゼロかどうかを「統計解析>連続変数の解析>1標本の平均値のt検定」で検定することもできる。その場合は結果として差の期待値と信頼区間が得られる。

例題

Rcmdrのメニューで「データ」の「パッケージ内のデータ」の「アタッチされたパッケージからデータセットを読み込む」(EZRでは「ファイル」「パッケージに含まれるデータを読み込む」)を選び,左側からdatasetsパッケージをダブルクリックし,右側からinfertデータフレームをダブルクリックすると,Trichopoulos et al. (1976) Induced abortion ans secondary infertility. Br J Obst Gynaec, 83: 645-650.で使われているデータを読み込むことができる。

アテネ大学の第一産婦人科を受診した続発性の不妊の100人の女性の1人ずつについて同じ病院から年齢,既往出生児数,教育歴をマッチングした健康な(不妊でない)女性2人ずつを対照として選ぶことを目指してサンプリングし,2人の対照が見つかった不妊患者が83人だったので,この患者と対照全員を含むデータである(ただし74組目だけ対照が1人しかデータに含まれていないので,249人でなく248人のデータとなっている。除かれたのはそれまでの自然流産と人工妊娠中絶が2回ずつあった人である)。

含まれている変数は以下の通りである。

education: 教育を受けた年数(3水準の要因型)

age: 年齢

parity: 既往出生児数

induced: それまでの人工妊娠中絶回数(2は2回以上)

case: 不妊の女性が1,対照が0

spontaneous: それまでの自然流産回数(2は2回以上)

stratum: マッチングした組の番号

pooled.stratum: プールした層番号(1) 不妊患者と対照の間で自然流産を経験した数に差がないという帰無仮説を検定せよ。(2)各女性の自然流産の経験数と人工妊娠中絶の経験数に差がないという帰無仮説を検定せよ。有意水準はともに5%とする。

本当は因果を逆に考えてロジスティック回帰またはポアソン回帰する方が筋がいいと思うが,ここでは敢えて平均値の差の検定をしてみる。2群間で分布が異なるし対照群では正規分布から明らかに外れているが,それにも目をつぶって平均値の差の検定を行う。2回以上というのを2回と扱っていいのかという点にも問題があるが,ここでは目をつぶる。Rコンソールでは,この操作は単純である。必要なt検定をするには,次のように打てば良い。

t.test(spontaneous ~ case, data=infert)とする。もし患者群と対照群の間で分散が等しいという帰無仮説を検定したいときは,

var.test(spontaneous ~ case, data=infert)t.test(infert$induced, infert$spontaneous, paired=TRUE)Rcmdrで群別に分布をみるには,群分け変数が要因型でなくてはならないので,まず「データ」の「アクティブデータセット内の変数の管理」の「数値変数を因子に変換」でcaseを因子型に変えておく。変数としてcaseを選び,因子水準は「水準名を指定」がチェックされた状態にして,新しい変数または複数の変数に対する接頭文字列のところが<変数と同じ>となっているのをgroupとして(ここは,複数の数値型変数を一度に因子型に変換するときは接頭文字列を入力するが,1つだけの場合は新しい変数名全体を打つ必要がある),因子型の変数名がgroupとなるように指定する。すると水準名を指定するウィンドウが開くので,0のところにcontrol,1のところにinfertileと打つ。そうやって準備をしておいてから,「グラフ」の「箱ひげ図」で「変数(1つを選択)」としてspontaneousを選び,「層別のプロット」ボタンをクリックして「層別変数(1つ選択)」としてgroupを選ぶと,対照群と不妊群別々に箱ひげ図を描くことができる。値が0, 1, 2しかないので箱ひげ図よりも棒グラフあるいはヒストグラムの方がわかりやすいが,棒グラフやヒストグラムはRcmdrでは層別でプロットできないため,ここでは箱ひげ図を採用した。もちろん「平均のプロット」で標準偏差をエラーバーとする平均値を線で結んだプロットをさせてもよい。

(1) 「統計量」の「平均」の「独立サンプルt検定」を選び(EZRでは「統計解析」「連続変数の解析」から「2群間の平均値の比較(t検定)」を選び),「等分散と考えますか?」で「No」にチェックが入っていることを確認し,グループをgroup,目的変数をspontaneousにして[OK]をクリックするとWelchの方法によるt検定が実行できる(なお,「統計量」の「分散」の「分散の比のF検定」でグループをgroup,目的変数をspontaneousとして両側検定を実行すると出力ウィンドウに表示されるp-valueが小さいので,2群の分散にも統計的な有意差があることがわかる)。

(2) 「統計量」の「平均」の「対応のあるt検定」を指定し(EZRなら「統計解析」「連続変数の解析」から「対応のある2群間の平均値の検定(paired t検定)」を選ぶ),第1の変数としてspontaneous,第2の変数としてinducedを選んで[OK]ボタンをクリックすれば実行できる。

Wilcoxonの順位和検定は,パラメトリックな検定でいえば,t検定を使うような状況,つまり,独立2標本の分布の位置に差がないかどうかを調べるために用いられる。Mann-WhitneyのU検定と(これら2つほど有名ではないが,KendallのS検定とも)数学的に等価である。Rcmdrでは,「統計量」の「ノンパラメトリック検定」を選んで実行する。

データがもつ情報の中で,単調変換に対して頑健なのは順位なので,これを使って検定しようという発想である。以下,Wilcoxonの順位和検定の手順を箇条書きする。

例として,surveyデータで,身長(Height)の分布の位置が男女間で差がないという帰無仮説を検定してみよう。

Rコンソールでは簡単で,library(MASS)してあれば,

> wilcox.test(Height ~ Sex, data=survey)だけで良い。

Wilcoxonの順位和検定の効果量については,https://core.ecu.edu/wuenschk/docs30/Nonparametric-EffectSize.pdfで説明されているように,p値からZ値を求めて(両側検定のp値から求める場合は2で割ることを忘れないように)サンプルサイズの平方根で割るという正規近似による方法と,effectsizeパッケージを使ってrank_biserial()関数を使う方法が知られている(得られる効果量はCliff's deltaといい,負の値も取り得るが,絶対値を解釈すれば良い)。この効果量rは,https://cran.r-project.org/web/packages/statsExpressions/vignettes/stats_details.htmlに書かれているように,0.1-0.3で小さい,0.3-0.5で中程度,0.5以上で大きいと判断するのが目安である。上記の例であれば,コードは以下。

> library(MASS)

> res <- wilcox.test(Height ~ Sex, data=survey)

> abs(qnorm(res$p.value/2))/sqrt(sum(complete.cases(survey[,c("Height", "Sex")])))

> library(effectsize)

> rank_biserial(Height ~ Sex, data=survey)Rcmdrでは「統計量」の「ノンパラメトリック検定」で「2標本ウィルコクソン検定」を選び,グループ変数としてSexを選び,応答変数としてHeightを選んで[OK]ボタンをクリックする。

EZRでは「統計解析」「ノンパラメトリック検定」から「2群間の比較(Mann-Whitney U検定)」を選び,目的変数としてHeightを,比較する群としてSexを選んで「OK」ボタンをクリックする。検定結果がOutputウィンドウに表示されるだけでなく,箱ひげ図も同時に描かれる。身長の性差の検定結果はWelchのt検定と同じく有意差があるといえる。

同じsurveyデータフレームで年齢(Age)に性差があるかどうかについては,Welchのt検定では有意でなかったが,Wilcoxonの順位和検定をすると5%水準で有意である。これはAgeの分布が大きく右裾を引いた歪んだ分布になっていて,しかも外れ値が多いため,Welchのt検定の検出力が低くなっているためである。

詳しくは,web上の三重大学奥村晴彦教授の解説記事65やhoxo_mさんの解説記事66を参照されると良いと思うが,「独立2群から一つずつ値を取り出したとき,どちらが大きい確率も等しい」という帰無仮説を検定するために67,BrunnerとMunzelが提案した比較的新しい方法である。残念ながら現在のところEZRには入っていない。

元論文は,Brunner E, Munzel U (2000) The nonparametric Behrens-Fisher problem: Asymptotic theory and a small-sample approximation. Biometrical Journal, 42: 17-25.であり,Rでは,lawstatパッケージのbrunner.munzel.test()で実行できる(使うためには,予めinstall.packages("lawstat", dep=TRUE)により,各種依存パッケージとともにlawstatパッケージをインストールしておく必要がある)。

上の例と同様に,MASSパッケージに入っているsurveyデータで,身長の分布の位置が男女で差がないという帰無仮説をBrunner-Munzel検定するには,

> library(lawstat)

> HT <- tapply(survey$Height,survey$Sex,print)

> brunner.munzel.test(HT$Male,HT$Female)とすれば良い。下枠内の結果が得られる。Ageについても同様に計算できるので確かめられたい。

Brunner-Munzel Test

data: HT$Male and HT$Female

Brunner-Munzel Test Statistic = -17.6824, df = 157.29, p-value < 2.2e-16

95 percent confidence interval:

0.0615193 0.1496350

sample estimates:

P(X<Y)+.5*P(X=Y)

0.1055771なお,サンプルサイズが極めて小さい場合は,Neubert K, Brunner E (2007) A studentized permutation test for the non-parametric Behrens-Fisher problem. Computational Statistics and Data Analysis, 51: 5192-5204.に示されているように,Brunner-Munzel統計量に並べ替え検定を適用すれば良いが(前掲した三重大学奥村晴彦教授の解説記事にコードが示されている),相当な計算時間がかかる。

最近開発された,brunnermunzelパッケージのbrunnermunzel.test()関数のperm=TRUEオプションを使えば(強引にさせたい場合はforce=TRUEオプションもつければ),高速な並べ替え検定が可能であるが,欠損値が含まれているとエラーが出るので,予め欠損値のないsubsetにしておくか,多重代入法などで欠損値を推定してから適用し結果を統合するという面倒なプロセスを踏まねばならないし,サンプルサイズが大きい場合もエラーが出て計算できない。

install.packages("brunnermunzel", dep=TRUE)によってbrunnermunzelパッケージをインストールした後,以下のコードを実行するとBrunner-Munzel検定ができるが,サンプルサイズが大きすぎて並べ替え検定の結果は得られない。

> library(brunnermunzel)

> mHT <- subset(survey, !is.na(Height)&Sex=="Male")$Height

> fHT <- subset(survey, !is.na(Height)&Sex=="Female")$Height

> brunnermunzel.test(mHT, fHT, perm=FALSE)

> brunnermunzel.test(mHT, fHT, perm=TRUE, force=TRUE) # エラーになるそこで,2種類の催眠剤(group)を10人の被験者(ID)に使った場合の睡眠時間増加(extra)データであるsleepを使って試すには(このデータは同じ人の2回の測定値であり,対応があるため,Brunner-Munzel検定には向いていないが,適当なサンプルサイズであるため使ってみた)以下の通り。

d1sleepextra <- subset(sleep, group=="1")$extra

d2sleepextra <- subset(sleep, group=="2")$extra

brunnermunzel.test(d1sleepextra, d2sleepextra, perm=FALSE)

brunnermunzel.test(d1sleepextra, d2sleepextra, perm=TRUE, force=TRUE)この結果のp値をみると,近似的な検定では0.04682と5%水準では有意だが,並べ替え検定では0.05513と有意でない。

Wilcoxonの符号付き順位検定は,対応のあるt検定のノンパラメトリック版である。ここでは説明しないが,多くの統計学の教科書に載っている。

実例だけ出しておく。surveyデータには,利き手の大きさ(親指と小指の先端の距離)を意味するWr.Hndという変数と,利き手でない方の大きさを意味するNW.Hndという変数が含まれているので,これらの分布の位置に差が無いという帰無仮説を有意水準5%で検定してみよう。

同じ人について利き手と利き手でない方の手の両方のデータがあるので対応のある検定が可能になる。Rコンソールでは,

> wilcox.test(survey$Wr.Hnd, survey$NW.Hnd, paired=TRUE)とすればよい。

Rcmdrでは,「統計量」,「ノンパラメトリック検定」,「対応のあるウィルコクソン検定」と選択し(EZRでは,「統計解析」「ノンパラメトリック検定」から「対応のある2群間の比較(Wilcoxonの符号付き順位和検定)」を選び),第1の変数として左側のリストからWr.Hndを選び,第2の変数として右側のリストからNW.Hndを選んで[OK]ボタンをクリックするだけである。順位和検定のときと同じく検定方法のオプションを指定できるが,通常はデフォルトで問題ない。

ちなみに,この検定結果はp=0.0825となり,5%水準で有意でない。対応のあるt検定では有意だったのにこうなるのは,データが正規分布に近い分布である場合には,t検定の方が検出力が大きいためである。Diff.Hndは分布の正規性の検定をするとShapiro-Wilkの検定で5%水準で有意に正規分布と差があるけれども(1人だけある外れ値を除外しても有意差あり),外れ値を除外してヒストグラムを描くと正規分布に近いように見える。こういう場合は,一般にt検定の方が検出力が高い。

食物摂取頻度調査の結果のように,頻度を順序尺度で示すデータについて,独立2群間での比較をしたい場合,(1)各頻度カテゴリを1つの数値で代表させ,量として扱うことでt検定する,(2)順序なのでWilcoxonの順位和検定(Mann-WhitneyのU検定)を行う,(3)順序の情報を無視してカテゴリとしてカイ二乗検定する,といった方法が良く行われているが,(1)は代表のさせ方が妥当である保証がなく,(2)は同順位が多くなると考えられるため正しいp値が得られない可能性が高く,(3)は順序の情報を捨ててしまうため検出力が下がるという問題がある。

このような場合,グループで順序を説明するという順序ロジスティック回帰と,定数で順序を説明する(つまり順序間に差が無い)という順序ロジスティック回帰の結果の尤度比をとり,尤度比検定をすることができる。EZRのメニューにはないが,以下に例を示す。yが6段階の順序尺度をもつ変数で,xがAとBの2群を示す変数である。

set.seed(123)

y1 <- c(sample(1:3, 20, rep=TRUE), sample(4:6, 30, rep=TRUE))

y2 <- c(sample(1:3, 30, rep=TRUE), sample(4:6, 20, rep=TRUE))

y <- as.ordered(c(y1, y2))

x <- as.factor(c(rep("A", 50), rep("B", 50)))

table(y, x)

library(MASS) # polr()関数を使うので

anova(polr(y ~ x), polr(y ~ 1)) # 尤度比検定

chisq.test(table(y, x)) # カイ二乗検定でもやってみる以下の結果が得られる。カイ二乗検定では順序の情報をまったく使わないので検出力が低く,xとyの独立性は棄却されないが,尤度比検定ではxの2群間で,yの値に,5%水準で有意な差があるといえる。

> table(y, x)

x

y A B

1 5 12

2 7 10

3 8 8

4 11 5

5 8 7

6 11 8

> anova(polr(y ~ x), polr(y ~ 1)) # 尤度比検定

Likelihood ratio tests of ordinal regression models

Response: y

Model Resid. df Resid. Dev Test Df LR stat. Pr(Chi)

1 1 95 357.7997

2 x 94 353.9071 1 vs 2 1 3.892613 0.04849892

> chisq.test(table(y, x)) # カイ二乗検定でもやってみる

Pearson's Chi-squared test

data: table(y, x)

X-squared = 6.2021, df = 5, p-value = 0.287

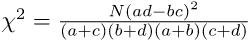

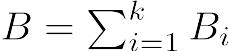

2つのカテゴリ変数間の関係としては,独立かどうか,独立でないとしたらどの程度の関連があるかを調べることになるが,2つのカテゴリ変数の関係が独立であるという帰無仮説は,第1のカテゴリ変数で示されるグループ間で,第2のカテゴリ変数で示される構成比に差がないという帰無仮説と同等である。これらのカテゴリ変数がともに2値変数である場合は,これは2群の母比率の差の検定に帰着する。

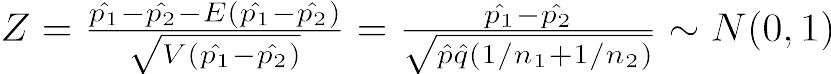

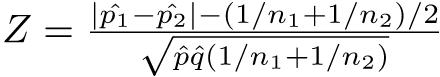

たとえば,患者群n1名と対照群n2名の間で,ある特性をもつ者の人数がそれぞれr1名とr2名だったとして,その特性の母比率に差がないという帰無仮説を考える。

2群の母比率p1とp2が,各々の標本比率p̂1 = r1 / n1及びp̂2 = r2 / n2として推定されるとき,それらの差を考える。差(p̂1 - p̂2)の平均値と分散は,E(p̂1 - p̂2) = p1 - p2V(p̂1 - p̂2) = p1(1 - p1) / n1 + p2(1 - p2) / n2となる。

2つの母比率に差が無いならば,p1 = p2 = pとおけるはずなので,V(p1 - p2) = p(1 - p)(1 / n1 + 1 / n2)となる。

このpの推定値として,p̂ = (r1 + r2)/(n1 + n2)を使い,q̂ = 1 − p̂とおけば,n1p1とn2p2がともに5より大きければ,標準化して正規近似を使い,

によって検定できる。即ち,このZは離散値しかとれないため,連続分布である正規分布による近似の精度を上げるために,連続性の補正と呼ばれる操作を加え,かつp1 > p2の場合(つまりZ > 0の場合)とp1 < p2の場合(つまりZ < 0の場合)と両方考える必要があり,正規分布の対称性から絶対値をとってZ > 0の場合だけ考え,有意確率を2倍する。即ち,

によって検定できる。即ち,このZは離散値しかとれないため,連続分布である正規分布による近似の精度を上げるために,連続性の補正と呼ばれる操作を加え,かつp1 > p2の場合(つまりZ > 0の場合)とp1 < p2の場合(つまりZ < 0の場合)と両方考える必要があり,正規分布の対称性から絶対値をとってZ > 0の場合だけ考え,有意確率を2倍する。即ち,

として,このZの値が標準正規分布の97.5%点(Rならば

として,このZの値が標準正規分布の97.5%点(Rならばqnorm(0.975, 0, 1))より大きければ有意水準5%で帰無仮説を棄却する。

数値計算をしてみるため,仮に,患者群100名と対照群100名で,喫煙者がそれぞれ40名,20名だったとする。喫煙率に2群間で差がないという帰無仮説を検定するには,

> p <- (40+20)/(100+100)

> q <- 1-p

> Z <- (abs(40/100-20/100)-(1/100+1/100)/2)/sqrt(p*q*(1/100+1/100))

> 2*(1-pnorm(Z))より,有意確率が約0.0034となるので,有意水準5%で帰無仮説は棄却される。つまり,喫煙率に2群間で差がないとはいえないことになる。

差の95%信頼区間を求めるには,サンプルサイズが大きければ正規分布を仮定できるので,原則どおりに差から分散の平方根の1.96倍を引いた値を下限,足した値を上限とすればよい。この例では,

> dif <- 40/100-20/100

> vardif <- 40/100*(1-40/100)/100+20/100*(1-20/100)/100

> difL <- dif - qnorm(0.975)*sqrt(vardif)

> difU <- dif + qnorm(0.975)*sqrt(vardif)

> cat("喫煙率の差の点推定値=", dif, " 95%信頼区間= [",difL,",",difU,"]\n")より,[0.076, 0.324]となる。しかし,通常は連続性の補正を行うので,下限からはさらに(1/n1 + 1/n2)/2 = (1/100 + 1/100)/2 = 0.01を引き,上限には同じ値を加えて,95%信頼区間は[0.066, 0.334]となる。

Rには,こうした比率の差を検定するための関数prop.test()が用意されており,以下のように簡単に実行することができる。

> smoker <- c(40, 20)

> pop <- c(100, 100)

> prop.test(smoker, pop)母比率の推定と,2群間でその差がないという帰無仮説の検定68,差の95%信頼区間を一気に出力してくれる。surveyデータフレームで「利き手が左である割合に男女で差が無い」という帰無仮説を検定するには,

> prop.test(table(survey$Sex, survey$W.Hnd))とすれば良い。

Rcmdrでは,「統計量」の「比率」から「2標本の比率の検定」を選ぶ。surveyデータフレームで,「利き手が左である割合に男女で差がない」という帰無仮説を検定するには,グループとしてSex,目的変数としてW.Hndを指定し,検定のタイプとして「連続修正を用いた正規近似」にチェックを入れて[OK]ボタンをクリックすればよい。

EZRでは,「統計解析」「名義変数の解析」から「分割表の作成と群間の比率の比較」を選ぶ。この例では,行の選択の枠からSex,列の変数の枠からW.Hndを選び,「仮説検定」のなかから「カイ2乗検定」の左のボックスにチェックを入れ,「カイ2乗検定の連続性補正」の下のラジオボタンを「はい」にして「OK」ボタンをクリックする。

2つのカテゴリ変数の関係を考えるとき,一般に,もっともよく行われるのは,それらが独立であるという帰無仮説を立てて検定することである。本節ではその仕組みについて説明する。

カテゴリ変数のもつ統計的な情報は,カテゴリごとの度数だけである。そこで,2つのカテゴリ変数の間に関係について検討したいときには,まずそれらの組み合わせの度数を調べた表を作成する(Rではtable()やxtabs()という関数が使える)。これをクロス集計表と呼ぶ。とくに,2つのカテゴリ変数が,ともに2値変数のとき,そのクロス集計は2×2クロス集計表[2 by 2 cross tabulation](2×2分割表[2 by 2 contingency table])と呼ばれ,その統計的性質が良く調べられている。以下では2×2分割表の例で独立性のカイ二乗検定とフィッシャーの正確確率検定を説明するが,これらはカテゴリが3つ以上あっても通用する。同じ目的で使われる検定に,別名G検定とも呼ばれる尤度比検定があるが,これはRではvcdパッケージのassocstats()関数で計算できる。

なお,2つのカテゴリ変数の両方が順序のあるカテゴリである場合の独立性の検定としては,「線形連関の検定」(出典:藤井良宜『Rで学ぶデータサイエンス1 カテゴリカルデータ解析』共立出版, pp.65-68,英語ではAgresti A (2002) Categorical Data Analysis. Hoboken, New Jersey: John Wiley & Sons.で,“linear-by-linear association test”と呼ばれている。SPSSの日本語版では「線型と線型による連関検定」と意味の通じにくい訳語になっているので注意)を使う方法もある。これは,2つの順序のあるカテゴリ変数の各個体に対して順序を整数のスコアとして与え,スコア間で計算したピアソンの積率相関係数を2乗した値にサンプルサイズから1を引いた値を掛けた統計量が,近似的に自由度1のカイ二乗分布に従うことから検定を実行するものであり,Rではcoinパッケージのlbl_test()関数で計算できる。

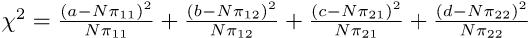

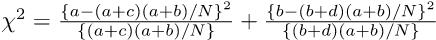

独立性の検定としては,2つのカテゴリ変数の間に関連がないと仮定した場合に推定される期待度数を求めて,それに観測度数が適合するかを検定するカイ二乗検定が最も有名である69。

| A | A | |

|---|---|---|

| B | a人 | b人 |

| B | c人 | d人 |

2つのカテゴリ変数AとBが,それぞれ「あり」「なし」の2つのカテゴリ値しかとらないとき,これら2つのカテゴリ変数の組み合わせは「AもBもあり(A ∩ B)」「AなしBあり(Ā ∩ B)」「AありBなし(A ∩ B̄)」「AもBもなし(Ā ∩ B̄)」の4通りしかない。それぞれの度数を数えあげた結果が,上記の表として得られたときに,母集団の確率構造が,

| A | A | |

|---|---|---|

| B | π11 | π12 |

| B | π21 | π22 |

であるとわかっていれば,N = a + b + c + dとして,期待される度数は,

| A | A | |

|---|---|---|

| B | Nπ11 | Nπ12 |

| B | Nπ21 | Nπ22 |

であるから,

として,自由度3のカイ二乗検定をすればよいことになる。しかし,普通,πは未知である。そこで,Pr(Ā) = 1 − Pr(A)かつ,この2つのカテゴリ変数が独立ならばPr(A ∩ B) = Pr(A)Pr(B)と考えれば良い70ことを使って,Pr(A)とPr(B)を母数として推定する71。Pr(A)の点推定量は,Bを無視してAの割合と考えれば(a + c)/Nであることは自明である。同様に,Pr(B)の点推定量は,(a + b)/Nとなる。したがって,π11 = Pr(A ∩ B) = Pr(A)Pr(B) = (a + c)(a + b)/(N2)となる。

として,自由度3のカイ二乗検定をすればよいことになる。しかし,普通,πは未知である。そこで,Pr(Ā) = 1 − Pr(A)かつ,この2つのカテゴリ変数が独立ならばPr(A ∩ B) = Pr(A)Pr(B)と考えれば良い70ことを使って,Pr(A)とPr(B)を母数として推定する71。Pr(A)の点推定量は,Bを無視してAの割合と考えれば(a + c)/Nであることは自明である。同様に,Pr(B)の点推定量は,(a + b)/Nとなる。したがって,π11 = Pr(A ∩ B) = Pr(A)Pr(B) = (a + c)(a + b)/(N2)となる。

同様に考えれば,母集団の各セルの確率は下式で得られる。 π12 = (b + d)(a + b)/(N2) π21 = (a + c)(c + d)/(N2) π22 = (b + d)(c + d)/(N2)

これらの値を使えば,

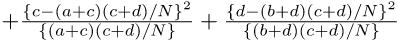

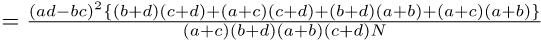

分子の中括弧の中はN2なので,結局,

分子の中括弧の中はN2なので,結局,

ただし通常は,イェーツの連続性の補正を行う。カイ二乗分布は連続分布なので,各度数に0.5を足したり引いたりしてやると,より近似が良くなるという発想である。この場合,

が自由度1のカイ二乗分布に従うと考えて検定する。なお,|ad − bc|がN/2より小さいときは補正の意味がないので,χ2 = 0とするのが普通である。|ad − bc| < N/2のとき,Rの

が自由度1のカイ二乗分布に従うと考えて検定する。なお,|ad − bc|がN/2より小さいときは補正の意味がないので,χ2 = 0とするのが普通である。|ad − bc| < N/2のとき,Rのchisq.test()ではYatesの元論文の主旨に従うということで補正されてしまうけれども,prop.test()では補正されない。

実際の検定はクロス集計表が既に得られているとき,例えばa=12, b=8, c=9, d=10などとわかっていれば,Rコンソールでは,次のように入力すれば行列の定義とカイ二乗検定ができる。

x <- matrix(c(12,9,8,10), 2, 2)

# x <- matrix(c(12,8,9,10), 2, 2, byrow=TRUE) is also possible.

chisq.test(x)Rcmdrでは,「統計量」「分割表」「2元表の入力と分析」で表示される表の各セルに直接数字を入力し,必要な統計量のチェックボックスにチェックを入れてOKボタンをクリックするだけである。

例題

肺がんの患者100人に対して,1人ずつ性・年齢が同じ健康な人を対照として100人選び(この操作をペアマッチサンプリングという),それぞれについて過去の喫煙の有無を尋ねた結果,患者群では過去に喫煙を経験した人が80人,対照群では過去に喫煙を経験した人が55人だった。肺がんと喫煙は無関係といえるか? 独立性のカイ二乗検定をせよ。

帰無仮説は,肺がんと喫煙が無関係(独立)ということである。クロス集計表を作ってみると,

| 肺がん患者群 | 健康な対照群 | 合計 | |

|---|---|---|---|

| 過去の喫煙経験あり | 80 | 55 | 135 |

| 過去の喫煙経験なし | 20 | 45 | 65 |

| 合計 | 100 | 100 | 200 |

となる。肺がんと喫煙が無関係だという帰無仮説の下で期待される各カテゴリの人数は,

| 肺がんあり | 肺がん無し | |

|---|---|---|

| 喫煙あり | 135×100/200=67.5 | 135×100/200=67.5 |

| 喫煙なし | 65×100/200=32.5 | 65×100/200=32.5 |

となる。従って,連続性の補正を行なったカイ二乗統計量は,

χc2 = (80 − 68)2/67.5 + (55 − 67)2/67.5 + (20 − 32)2/32.5 + (45 − 33)2/32.5 = 13.128...となり,自由度1のカイ二乗分布で検定すると1-pchisq(13.128,1)より有意確率は0.00029...となり,有意水準5%で帰無仮説は棄却される。つまり,肺ガンの有無と過去の喫煙の有無には5%水準で統計学的に有意な関連があるといえる。

Rコンソールでは次の1行を打つだけで上の結果を得ることができる。

chisq.test(matrix(c(80, 20, 55, 45), 2, 2))Rcmdrでは,「統計量」「分割表」「2元表の入力と分析」で,対応するセルに直接人数を入力して[OK]をクリックすればよい。

例題

MASSパッケージのsurveyデータフレームで,性別(Sex)が利き手(W.Hnd)と独立であるという帰無仮説を検定せよ。

Rコンソールでは次の2行を打てばできる。

require(MASS)